« J’ai encaissé deux fois plus d’argent en une seule journée que ce que je touche d’habitude en un mois ! »

Andy Othling est musicien. Il est guitariste de tournée pour Future of Forestry et il a enregistré des albums personnels sous le nom Lowercase Noises.

Sa musique est cool et planante :)

Mais ce qui est encore plus cool c’est la très originale et probante expérience qu’il vient de mener sur Internet.

Sous le régime du copyright classique, ses albums sont présents sur le site de vente de musique en ligne Bandcamp (en passant cette plateforme est sans DRM et propose la format FLAC et Ogg Vorbis).

Présents et tous payants, sauf pendant 24h…

C’est le récit de cette folle journée qu’il vous raconte ci-dessous.

Attention, les conclusions pourront fortement heurter la sensibilité de certains hadopistes !

Que se passe-t-il lorsque votre musique est gratuite pendant une journée ?

What happens when your music is free for a day?

Andy Othling - 23 octobre 2012 - Blog personnel

(Traduction : Cyrille L., ehsavoie, Martin, Gatitac, Yann, ZeHiro, geecko, Naar, Sparty, Gaëtan, e-Jim, Tchevengour)

Il existe un débat houleux pour savoir si donner gratuitement sa musique est une bonne pratique ou non. Certains disent que cela dévalorise votre musique et vous empêche d’être pris au sérieux. D’autres pensent que c’est nécessaire pour attirer l’attention du public sur celle-ci.

Ce billet n’est pas là pour vous faire adhérer à l’une ou l’autre de ces thèses, mais plutôt pour vous présenter les résultats d’une expérience que j’ai menée il y a quelques semaines. J’ai voulu voir ce qu’il se passerait si je mettais toute ma musique à prix libre (avec un minimum de 0 $) sur ma page Bandcamp pendant 24 heures.

Comment je m’y suis pris

Voici comment j’ai travaillé : j’ai programmé l’envoi d’un e-mail à ma liste de diffusion le 4 octobre à 1 heure du matin annonçant à tout le monde que toute ma musique était disponible à prix libre, à partir de 0 $, et leur indiquant de faire passer le message à toutes leurs connaissances.

J’ai aussi programmé des mises à jour de mes statuts Facebook et Twitter pour la même heure, en demandant aux gens de diffuser l’information les prochaines 24 heures. Ensuite, j’ai programmé des tweets toutes les 2 à 4 heures et des mises à jour du statut Facebook toutes les 4 à 6 heures durant les 24 heures de l’opération, afin de leur rappeler l’offre spéciale.

Les résultats

C’était attendu, l’un des résultats est que beaucoup plus de personnes ont eu accès à ma musique. Ils ont tapé 0 $ et ont téléchargé tout ce qu’ils voulaient gratuitement. Mais d’autres choses intéressantes se sont produites.

Sur Bandcamp, le nombre de téléchargements est le facteur principal de la notoriété.

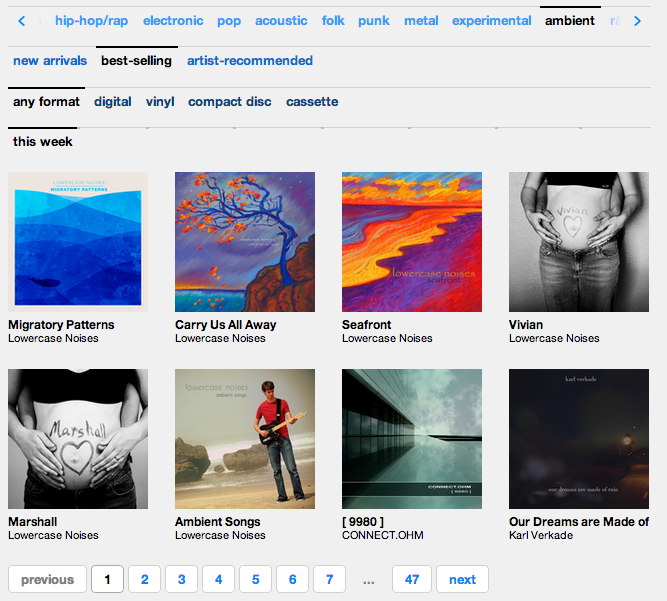

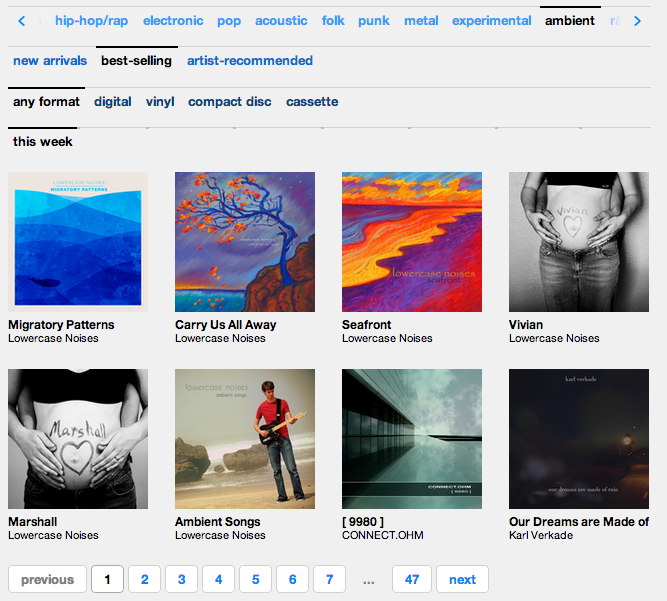

Puisqu’un grand nombre de personnes ont téléchargé ma musique (gratuitement ou non), mes albums furent propulsés en haut de beaucoup de listes du site. L’image ci-dessous montre les albums d’ambiance les plus vendus de ce jour si spécial :

Comme vous pouvez le voir, mes six albums sont directement en haut de cette section. Génial ! (Y voir aussi Karl Verdake me réjouis !)

Être en haut de ces listes, c’est plus de nouveaux visiteurs.

Parce que ma musique a atteint les sommets de certaines listes de Bandcamp, elle est devenue plus visible à ceux qui parcouraient ces listes ce jour-là. Ci-dessous, quelques captures d’écran des pages de statistiques de Bandcamp du jour J :

Plus de 100 personnes sont allées écouter ma musique depuis la page d’accueil de Bandcamp et 50 autres l’ont fait grâce aux listes mentionnées plus haut. Ce sont des personnes qui ne connaissaient pas même l’existence de ma musique.

Les gens se sont vraiment passés le mot.

Je n’ai eu aucune honte a demander aux gens de diffuser autour d’eux que mes morceaux restaient gratuits pendant ces 24 heures. Grâce à cela, quelqu’un a spontanément relayé l’info sur Reddit. Comme vous pouvez le voir ci-dessous, cela m’a apporté encore plus de nouveaux auditeurs :

Une fois de plus, 202 nouveaux auditeurs rien qu’en demandant aux gens d’en parler autour d’eux !

Les gens continuaient de payer pour ma musique.

Maintenant, vous vous demandez probablement qu’est-ce que ça a donné en terme de rentabilité. J’avais prévu une chute des revenus, car c’est généralement ce à quoi on s’attend quand on commence à distribuer les choses sans contrepartie. Mais ce qui est en fait arrivé, c’est que, sur les ventes, j’ai encaissé deux fois plus en une seule journée que ce que je touche d’habitude EN UN MOIS. Oui, parfaitement, vous lisez bien. Une journée a davantage rapporté que deux mois en temps normal !

Je ne suis pas vraiment capable d’expliquer cela, mais je pense que ça s’est joué pour beaucoup sur la générosité réciproque. Les gens ont vraiment semblé apprécier que je fasse ce geste et ont répondu en donnant plus qu’ils ne le faisaient auparavant. J’ai ainsi été stupéfait par ceux qui ont décidé de donner davantage pour un album que le prix qu’il leur aurait coûté la veille.

Le plus important : les contacts

Plus d’argent, c’est génial, mais à mon avis ce n’est pas le plus grand succès de cette expérience.

Vous pouvez constater qu’en une journée, j’ai ajouté plus de 450 noms à mon carnet d’adresses. Ce sont 450 nouveaux contacts dont je pourrais bénéficier à l’avenir, et 450 personnes de plus qui peuvent à leur tour relayer l’info si jamais je venais à répéter ce genre d’opération. C’est bien plus important à mes yeux que l’argent.

Récapitulatif

Donc, que s’est-t-il passé là?

- Beaucoup de personnes ont récupéré ma musique gratuitement ;

- J’ai gagné beaucoup d’argent de manière inattendue ;

- J’ai de nouveaux auditeurs et des contacts pour mes prochaines sorties d’albums.

D’après moi, c’est du gagnant-gagnant. Il n’y a vraiment eu aucun coût pour moi à réaliser cette expérience, les gains se sont avérés énormes et mes auditeurs n’ont pas été abusés. Pour ne rien vous cacher mon taux de téléchargements payants a baissé de 22% à 8%, mais étant donné tout ce qui est arrivé, cela ne me gêne pas le moins du monde.

Alors, que cela signifie-t-il pour vous en tant qu’artiste ? C’est un peu plus dur à dire, étant donné que cela dépend de ce que vous avez mis en place et que la situation de chacun est différente. Mais, cela montre au moins l’importance de l’expérimentation. N’hésitez pas à essayer des choses pour voir à quoi vos fans vont réagir. Vous devez apprendre d’eux comme ils ont appris de vous.

Question : Et vous, avez-vous déjà proposé votre musique gratuitement ou bien à prix libre ? Cela a-t-il fonctionné ?

Crédit photo : Knate Myers

Original post of Framablog.Votez pour ce billet sur Planet Libre.

![]()