Des partenariats Public-Privé aux partenariats Public-Communs (A propos du Google Cultural Institute)

vendredi 13 décembre 2013 à 08:58L’ouverture du Google Cultural Institute aura marqué les esprits cette semaine, notamment à cause de la décision de la Ministre de la Culture, Aurélie Filippetti, de boycotter la cérémonie et de la réaction du gouvernement qui a envoyé Fleur Pellerin à la place dans une certaine confusion.

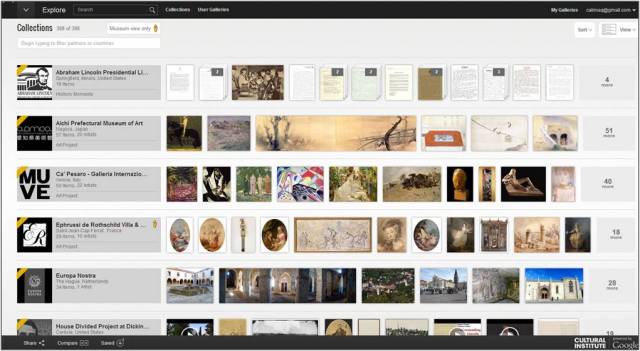

Mais ces péripéties gouvernementales ont fait oublier ce qui était sans doute le plus important : à savoir que Google a mis en place avec le Google Cultural Institute un site appelé à jouer un rôle non négligeable dans l’environnement numérique, rassemblant plus de 6 millions d’oeuvres en provenance de plus de 400 établissements culturels dans le monde. Voilà ce qu’en dit Le Mouv’ :

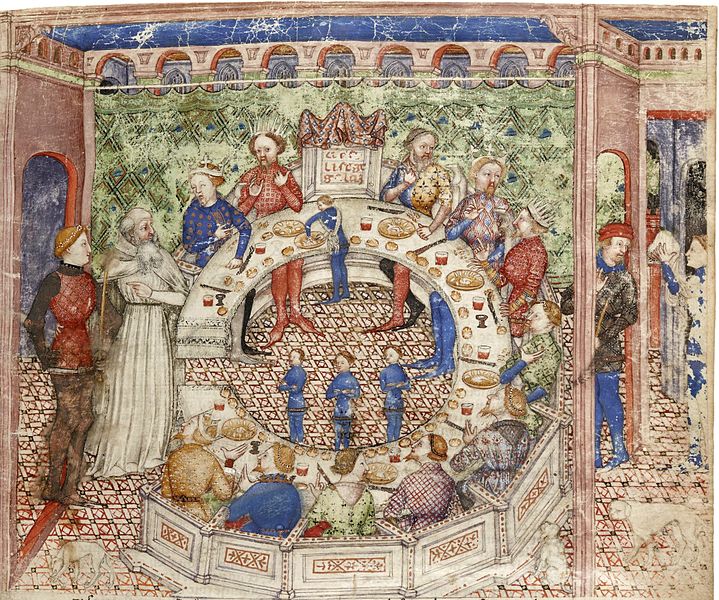

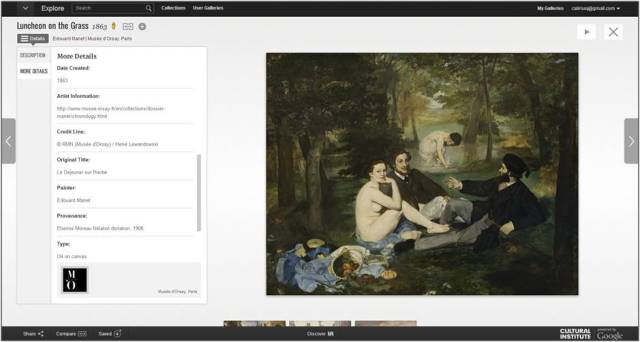

L’Institut culturel consiste donc en une plate-forme, sorte de gallerie des oeuvres et créations du monde, qui permet d’accéder à tout un tas d’oeuvres d’arts, mais aussi de monuments ou de merveilles naturelles. Telle une Google Map customisée, cette plate-forme permet aussi bien de voir les Alpes, d’admirer un Van Gogh ou de se balader à l’intérieur du musée d’Orsay. Pour un résultat, il faut le reconnaître, assez bluffant: 40 000 images d’oeuvres sont disponibles, certaines d’entre elles peuvent être étudier à un niveau de détail inégalé et la recherche par date, médium, artiste… est très pratique. Le rêve pour tout étudiant en Histoire de l’art ou Arts Plastiques.

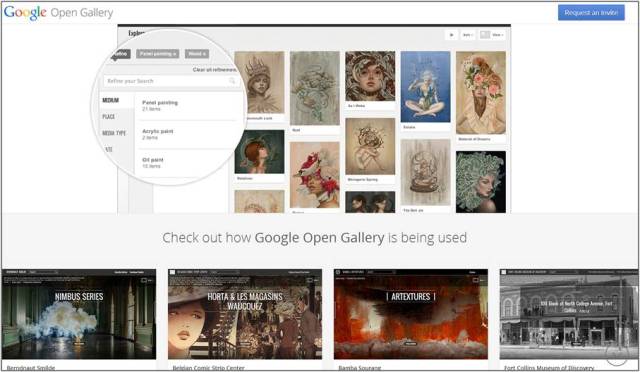

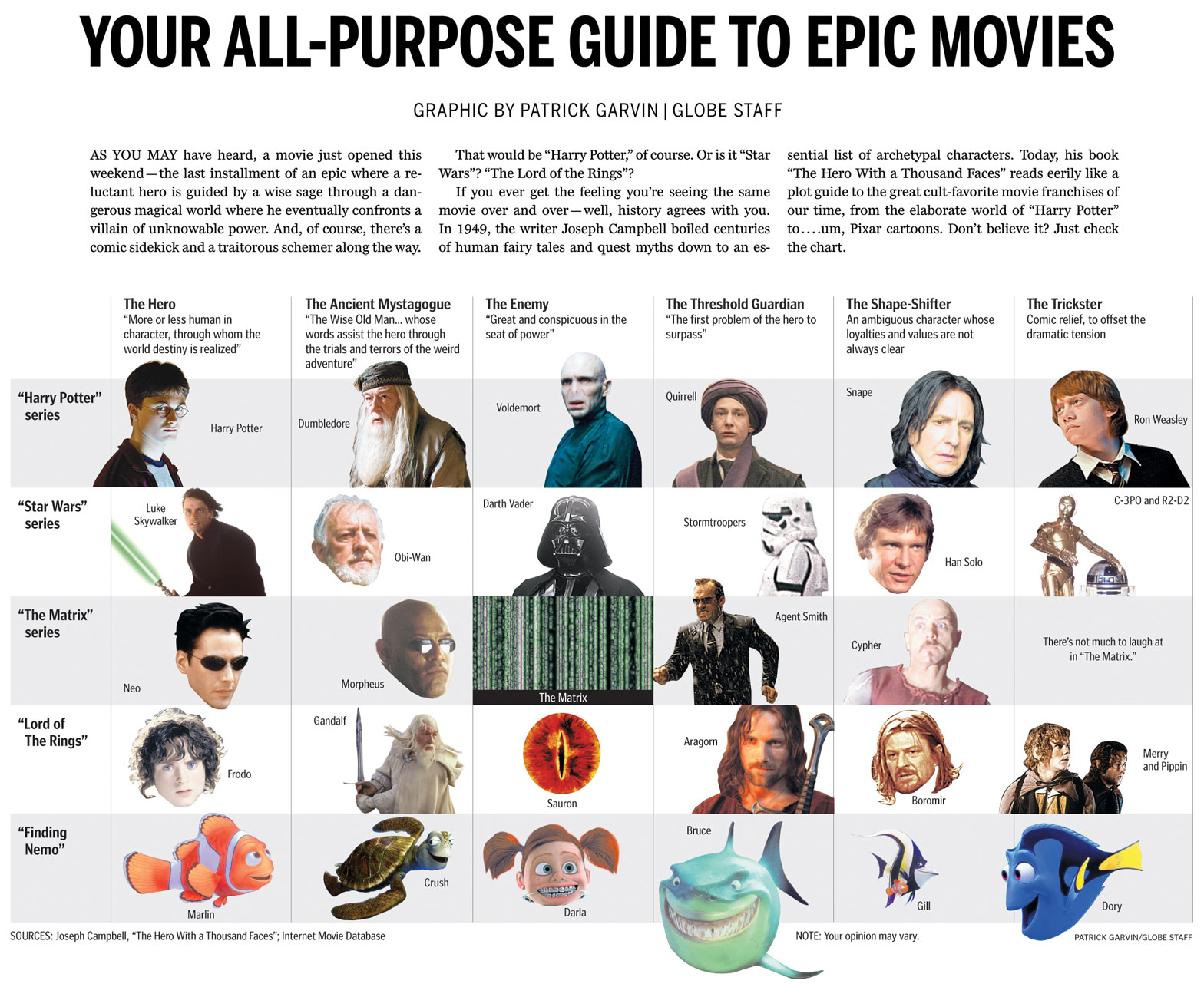

Faisant suite au Google Art Project lancé en 2011, cette nouvelle plateforme offre aux institutions la possibilité de présenter leurs collections sous la forme d’expositions virtuelles. L’outil est de grande qualité et il restait pour l’instant ouvert uniquement à des institutions partenaires de Google. Mais à l’occasion de cette inauguration du Google Cultural Institute à Paris, la firme de Moutain View a annoncé le lancement d’un autre site, Google Open Gallery, qui permettra à n’importe quel musée, archives, bibliothèque, mais aussi artiste individuel, de charger ses propres images et de les éditorialiser avec des outils gratuits. D’une certaine manière, Google s’oriente vers une forme assez révolutionnaire de "YouTube de l’art et de la culture", avec la force de frappe qu’on lui connaît.

Une "cage de verre" pour le domaine public numérisé

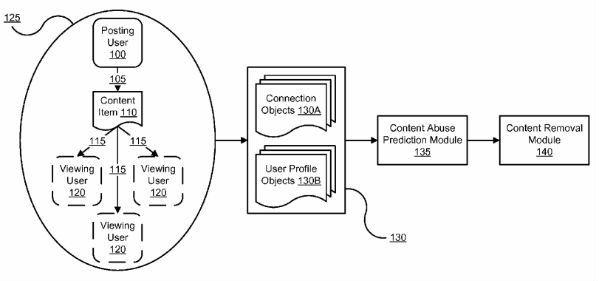

Tout ceci pourrait paraître comme un mouvement positif, offrant à des institutions culturelles le moyen de gagner en visibilité, mais les choses sont plus complexes que cela lorsque l’on regarde dans le détail. Creative Commons France a publié un billet, intitulé "Institut Culturel Google et les oeuvres du domaine public" qui pointe un problème majeur déjà évoqué par Adrienne Alix notamment, il y a deux ans, à propos du Google Art Project. Parmi les oeuvres numérisées figurant sur la plateforme, une très large proportion appartiennent au domaine public, mais pourtant ses conditions d’utilisation placent les contenus sous "copyright : tous droits réservés". Pire encore, Google Open Gallery n’a rien de spécialement "Open", puisque les conditions générales des services Google s’y appliquent, ce qui signifie que la firme se voit accorder une licence d’utilisation très large sur les contenus postés par les utilisateurs.

Malgré la qualité des outils de visualisation et d’éditorialisation fournis par Google aux institutions culturelles, le Google Cultural Institute constitue une sorte de "cage de verre" qui rajoute une couche de droits sur le domaine public numérisé et empêche sa libre réutilisation. Pire, le clic droit est même désactivé ce qui empêche jusqu’à la copie des contenus à des fins personnelles. On est bien en présence d’une forme de copyfraud et d’enclosure posée sur le domaine public.

Pourtant, il serait trop rapide d’accuser uniquement Google d’être responsable de ces restrictions, car en effet, comme le rappelle BlankTextField sur Twitter, les institutions partenaires de Google (En France, le Château de Versailles, le Musée d’Orsay, Le Musée du Quay Branly, Le Musée de l’Orangerie, etc) pratiquent elles aussi largement le copyfraud sur leurs propres sites, en copyrightant le domaine public.

La fermeture de Google Art Project semble moins imputable à Google qu'à ses partenaires des musées bit.ly/19jG7tF cc @cc_fr @calimaq

—

(@BlankTextField) December 12, 2013Avec le Google Cultural Institute, on est donc en présence d’une forme de partenariat Public-Privé qui conduit à une enclosure sur le domaine public numérisé. Or ce type de dérives n’est pas une fatalité et des institutions publiques peuvent tout à fait coopérer avec des entités privées pour produire ensemble des biens communs numériques. Mais il faut pour cela passer d’une logique de partenariats Public-Privé à des partenariats Public-Communs.

Des partenariats Public-Communs, respectueux du domaine public

L’expression "partenariat Public-Communs" (Public-Commons Partnership) a été proposée par l’italien Tommaso Fattori, qui souhaitait montrer qu’il existe une autre voie possible que les partenariats Public-privé classiques, trop souvent à l’origine de formes de privatisation ou d’accaparement de ressources communes.

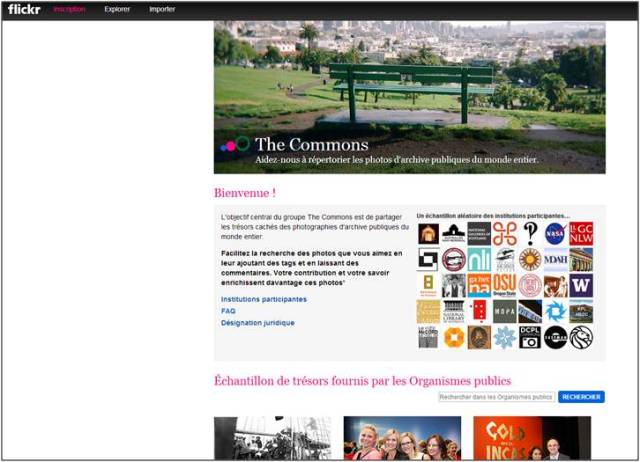

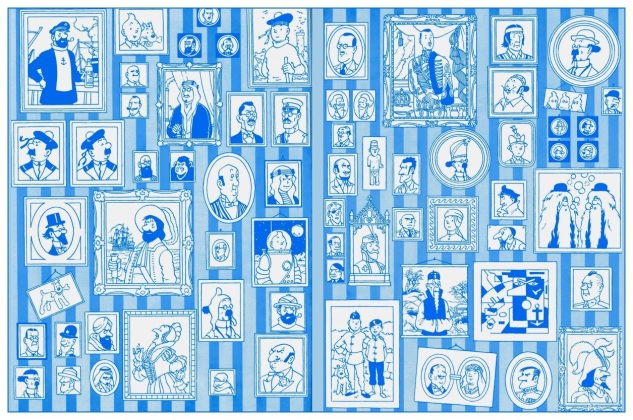

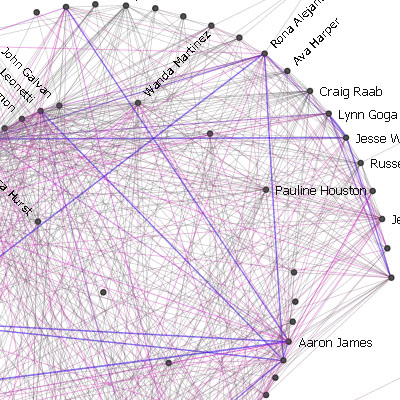

Dans le champ de la diffusion du patrimoine culturel en ligne, il existe justement un précédent qui incarne bien cette idée. Il s’agit du programme Flickr The Commons, initié en 2008 par un partenariat entre Flickr et la Bibliothèque du Congrès pour diffuser des fonds de photographies anciennes. Depuis, ce site a connu un grand succès et des dizaines de bibliothèques, musées et archives partout dans le monde ont choisi de l’utiliser pour exposer une partie de leurs collections.

Or du point de vue juridique, il existe une grande différence entre Flickr The Commons et le Google Cultural Institute : les institutions partenaires de Flickr (détenu par Yahoo!, rappelons-le) ne peuvent pas rajouter de couches de droits supplémentaires sur le domaine public. Le programme n’a mis en place qu’une seule mention "Aucune restriction de copyright connue" applicable à toutes les images sur la plateforme, qui permet la diffusion du domaine public "à l’état pur" sans copyfraud. Ces contenus culturels deviennent alors librement réutilisables par les communautés d’utilisateurs, y compris à des fins commerciales. On voit donc avec cet exemple comment un partenariat Public-privé peut se transformer en partenariat Public-Communs.

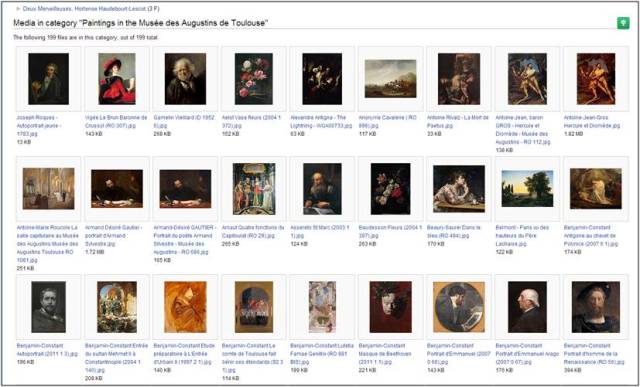

L’autre exemple que l’on peut citer de coopération orientée vers la constitution de biens communs, ce sont bien sûr les partenariats entre Wikimedia Commons et les institutions culturelles. Pour prendre un exemple français, on peut prendre le cas du Musée des Augustins de Toulouse, qui a choisi de publier sur Wikimedia Commons l’ensemble de ses collections de peintures et de sculptures exposées dans ses salles publiques. Là aussi, les reproductions numériques sont disponibles sans couche de droits supplémentaires, ce qui respecte l’intégrité du domaine public.

L’ouverture protège, la fermeture menace

L’intérêt principal à mon sens de ces partenariats Public-Communs, c’est qu’ils évitent de déséquilibrer l’écosystème numérique en conférant à un seul acteur une position dominante. Flickr The Commons ou Wikimedia Commons ne sont qu’un point de diffusion possible du domaine public numérisé parmi d’autres. La liberté de réutilisation qui est garantie sur ces plateformes fait que les contenus peuvent être réutilisés librement par des tiers, évitant ainsi de favoriser un acteur en particulier. Dans l’environnement numérique, ce qui appartient à tous ne peut plus être approprié par un seul et c’est la meilleure façon de se protéger des enclosures.

La situation est différente avec le Google Cultural Institute. En bloquant la réutilisation à l’extérieur de la plateforme de Google, les institutions culturelles partenaires confèrent à ce dernier un avantage comparatif très important et renforcent sa position dans l’écosystème. Dans ce type de partenariats, il y a en réalité "collusion" entre les acteurs institutionnels et l’acteur privé, et c’est au final le public – nous tous – qui nous voyons privés des droits culturels légitimes que le domaine public devrait pourtant nous offrir. Cette conception "propriétaire" de la culture et du patrimoine fait en définitive complètement le jeu de Google.

Sans surprise, les tableaux du Musée d’Orsay sont aussi copyrightées sur le Google Cultural Institute que sur son propre site. A qui la faute ?

Si Google s’était au contraire engagé dans un programme similaire à celui de Flickr, en mettant en place des conditions d’utilisation respectueuses du domaine public sans laisser le choix aux institutions partenaires, son Institut Culturel aurait pu constituer un outil intéressant pour faire évoluer les pratiques et apporter sa contribution à la formation de nouveaux biens communs de la connaissance. Mais tel n’est pas le cas et c’était son intérêt bien compris…

Quelle lisibilité pour la politique du Ministère de la Culture ?

C’est la raison pour laquelle le boycott par Aurélie Filippetti du lancement du Google Cultural Institute constitue sans doute en lui-même une décision opportune. La Ministre de la Culture a avancé comme argument pour justifier son absence le fait de ne pas vouloir "servir de caution" à Google, notamment tant que la firme n’a pas apporté de réponses satisfaisantes aux critiques qui lui sont faites quant à sa stratégie d’optimisation fiscale ou au respect des données personnelles des utilisateurs, deux points essentiels qui sont au coeur de la position dominante que cet acteur a su construire.

Par ailleurs, dans l’interview accordée au Monde pour annoncer son intention de boycotter l’inauguration, Aurélie Filippetti fait référence aux orientations prises en faveur du domaine public et de l’ouverture des données culturelles à l’issue de "l’Automne numérique " du Ministère de la Culture qui a eu lieu au mois d’octobre dernier et que j’avais saluées dans S.I.Lex :

Par ailleurs, dans « l’automne numérique » (politique numérique du ministère) sont traités des sujets comme la mise en valeur du domaine public et l’ouverture des données du domaine public culturel, poursuit la ministre.

Le Ministère de la Culture a aussi déclaré vouloir "veiller à «l’équilibre» des contrats entre les établissements culturels et Google".

Tous ces motifs sont légitimes, s’ils renvoient bien à ces problèmes d’enclosure que j’ai pointés plus haut. Mais on regrette que le message envoyé à Google, mais aussi aux institutions culturelles françaises, n’ait pas été plus clair. Hier matin par exemple, alors qu’elle était invitée sur France Inter à s’expliquer à propos de son boycott, Aurélie Filippetti n’a plus du tout parlé de la question du domaine public, pour en revenir à un discours beaucoup plus vague sur la protection de "l’exception culturelle française", calibré pour plaire aux industries culturelles françaises.

Par ailleurs, de vraies questions de cohérence globale de la politique du Ministère de la Culture se posent, car pour avoir boycotté le Google Cultural Institute, Aurélie Filippetti n’en a pas moins soutenu cette année d’autres partenariats public-privé, comme ceux conclus pour la numérisation des collections de la BnF, qui posaient pourtant de graves questions de respect de l’intégrité du domaine public. Par ailleurs, les établissements culturels français sont légion à pratiquer le copyfraud lorsqu’ils diffusent le domaine public numérisé, exactement de la même manière que sur le Google Cultural Institute.

Si le Ministère de la Culture veut aller au bout des nouvelles orientations qui ont été prises depuis plusieurs mois en faveur du domaine public et de l’ouverture des données culturelles (voir par exemple le Guide dataculture paru en mars dernier), il faut à présent franchir un pas supplémentaire, en demandant explicitement à ses établissements publics de ne plus entraver la libre réutilisation du domaine public numérisé et en privilégiant des partenariats Public-Communs.

Le Ministère peut aussi arriver à ce résultat en soutenant la loi sur le domaine public en France, qui a été déposée par la députée Isabelle Attard le mois dernier à l’Assemblée nationale.

Mise à jour du 14 décembre 2013 : Hier a été annoncé un exemple significatif de partenariats Public-Communs. La British Library a choisi de libérer UN MILLION d’images du domaine public sur Flickr The Commons. C’est une contribution majeure à la constitution de biens communs numériques et une manière de diffuser le domaine public en respectant son intégrité.

Classé dans:Domaine public, patrimoine commun Tagged: aurélie filippetti, Biens Communs, Domaine public, Google, Google Cultural Institute, Google Open gallery, ministère de la culture, partenariats public-privé

![]()