Alain Hertay, maître-assistant à la Haute Ecole de la Province de Liège, avait voulu m’interviewer l’été dernier, dans le cadre du projet FORMEAM, plateforme liégeoise de formation en matière d’éducation aux médias qui a pour objectif de faire poser aux étudiants bacheliers un regard critique sur le Web et les réseaux sociaux.

Il voulait que je revienne sur la génèse d’Une contre-histoire de l’Internet, le documentaire qui m’avait permis d’interviewer (notamment) Julian Assange, Benjamin Bayart, Valentin Lacambre, Andy Müller-Maghun,Richard Stallman, Phil Zimmermann… entre autres défenseurs des libertés. C’était juste avant les révélations Snowden qui, sur ces questions, a notablement contribué à changer la donne.

L’interview n’étant pas encore publiquement accessible, et alors que ce fut l’une des plus longues qu’il m’ait été donné d’accorder (voir aussi la page Interviews & docus TV, en #replay), Alain m’a autorisé à la republier sur ce blog.

Une contre–histoire de l’Internet : entretien avec Jean-Marc Manach

Né en 1971, Jean-Marc Manach est un pionnier du journalisme d’investigation sur l’internet et du « datajournalisme ». Il a beaucoup écrit sur la sécurité informatique et la protection des sources, aux sujets desquels il est intervenu à Science Po, Reporters sans frontières, au CF(P)J, à l’ESJ et dans plusieurs écoles de journalisme… Il est notamment blogueur au Monde (Bug Brother), animateur du #14h42 pour Arrêts sur Images et NextInpact, ex-grand reporter au Vinvinteur sur France 5… Il a aussi travaillé à Owni, InternetActu, Transfert.net, Vendredi… Il a contribué à plusieurs sites et campagnes de défense des droits de l’homme et de la vie privée.

Né en 1971, Jean-Marc Manach est un pionnier du journalisme d’investigation sur l’internet et du « datajournalisme ». Il a beaucoup écrit sur la sécurité informatique et la protection des sources, aux sujets desquels il est intervenu à Science Po, Reporters sans frontières, au CF(P)J, à l’ESJ et dans plusieurs écoles de journalisme… Il est notamment blogueur au Monde (Bug Brother), animateur du #14h42 pour Arrêts sur Images et NextInpact, ex-grand reporter au Vinvinteur sur France 5… Il a aussi travaillé à Owni, InternetActu, Transfert.net, Vendredi… Il a contribué à plusieurs sites et campagnes de défense des droits de l’homme et de la vie privée.

Nous l’avons rencontré pour évoquer son parcours, la genèse du film Une contre-histoire de l’Internet dont il est l’auteur, ainsi que ses projets à venir.

1. Une contre-histoire de l’Internet : entre contre-culture et histoire populaire

Tout d’abord, pouvez-vous nous raconter quelle est l’origine du film Une contre-histoire de l’Internet ? Comment celui-ci a-t-il été produit et réalisé ? En quoi ce film s’inscrit-il dans votre trajet journalistique ?

Tout est parti de David Dufresne. En 1995, au tout début du Web, il a commencé en créant un webzine qui s’appelait La Rafale. Il n’avait pas un profil journalistique. Il venait de la contre-culture comme moi. A la base, j’ai une formation de cinéaste et de critique cinéma. Donc, comme lui, je n’ai pas du tout un profil journalistique. David est ensuite devenu journaliste à Libération où il a beaucoup travaillé sur Tarnac et il a fait pas mal de web-docs. Si je vous parle de cela, c’est parce que, à la fin des années 90, je faisais partie d’un groupe de webmasters comme on disait à l’époque, groupe qui défendait la liberté d’expression, et qui s’appelait le Mini-rézo. On avait créé un site pour défendre les questions de liberté sur Internet.

Tout est parti de David Dufresne. En 1995, au tout début du Web, il a commencé en créant un webzine qui s’appelait La Rafale. Il n’avait pas un profil journalistique. Il venait de la contre-culture comme moi. A la base, j’ai une formation de cinéaste et de critique cinéma. Donc, comme lui, je n’ai pas du tout un profil journalistique. David est ensuite devenu journaliste à Libération où il a beaucoup travaillé sur Tarnac et il a fait pas mal de web-docs. Si je vous parle de cela, c’est parce que, à la fin des années 90, je faisais partie d’un groupe de webmasters comme on disait à l’époque, groupe qui défendait la liberté d’expression, et qui s’appelait le Mini-rézo. On avait créé un site pour défendre les questions de liberté sur Internet.

Or, à la fin des années 2000, Nicolas Sarkozy voulait civiliser Internet, ce que j’ai traduit par : « Cela veut dire que les internautes sont des barbares ». En réponse à cette campagne assez haineuse et à cette incompréhension crasse d’Internet, je me suis dit que cela serait intéressant de raconter comment, dès les années 90, des particuliers, des internautes, des webmasters, donc des gens qui n’étaient pas journalistes à la base, ont commencé à défendre la liberté d’expression et les libertés sur Internet. La Contre-histoire, initialement, c’était ça. C’était raconter cette histoire qui n’a jamais été racontée : comment, en France, dès les années 90, des gens ont essayé de se battre pour des valeurs qui sont devenues depuis des valeurs grand public avec les révélations de Snowden.

A l’époque, David Dufresne est parti vivre au Canada pour faire ses web-docs. On n’a pas pu travailler ensemble sur le film même s’il est interviewé dans le documentaire. Je me suis retrouvé à récupérer ce projet. Je travaillais alors à owni.fr, un site web où on expérimentait beaucoup les nouvelles formes de journalisme, notamment, le datajournalisme sur Internet. On était vus comme une sorte de laboratoire de recherches et de développements de la presse sur Internet. Il y avait plein de gens qui défilaient en permanence à la rédaction pour venir nous rencontrer et notamment les gens de Premières lignes : Paul Moreira et Luc Hermann. On a parlé de notre projet de documentaire pour raconter la défense des libertés sur Internet. Ils ont été intéressés. Ils étaient en contact avec ARTE qui a dit : « Oui, à condition que vous racontiez cela à un niveau mondial et pas seulement au niveau français ». Moi, je n’avais pas envie de voyager, je n’aime pas voyager, je préfère être devant mon écran d’ordinateur et je trouvais que raconter les défenses des libertés au niveau mondial, c’était quasiment impossible à faire en 90 minutes. Sauf qu’ARTE nous a bien coachés avec Premières lignes et, de fil en aiguille, cela a donné La contre-histoire de l’Internet.

D’où vient le choix du titre ?

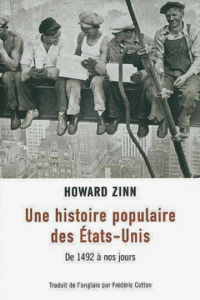

Le titre du film est un hommage au livre Une Histoire populaire des Etats-Unis d’Howard Zinn. C’est un historien américain qui a fait l’inverse de ce que font la majeure partie des journalistes et des documentaristes : il n’a pas raconté l’histoire des Etats-Unis du point de vue de ceux qui ont gagné la guerre mais du point de vue des Indiens, des esclaves, des suffragettes, des syndicalistes qui ont été pour certains fusillés par la garde civile américaine ou matraqué par des nervis payés par les patrons américains… C’est pour cela qu’il appelle son livre Une Histoire populaire des Etats-Unis, parce que c’est vu du côté du peuple et non pas du côté du pouvoir. Ce livre m’avait influencé à l’époque pour La contre-histoire de l’Internet. C’était cette même idée. Je voulais raconter l’histoire de l’Internet du côté de ceux qui l’ont fait.

Le titre du film est un hommage au livre Une Histoire populaire des Etats-Unis d’Howard Zinn. C’est un historien américain qui a fait l’inverse de ce que font la majeure partie des journalistes et des documentaristes : il n’a pas raconté l’histoire des Etats-Unis du point de vue de ceux qui ont gagné la guerre mais du point de vue des Indiens, des esclaves, des suffragettes, des syndicalistes qui ont été pour certains fusillés par la garde civile américaine ou matraqué par des nervis payés par les patrons américains… C’est pour cela qu’il appelle son livre Une Histoire populaire des Etats-Unis, parce que c’est vu du côté du peuple et non pas du côté du pouvoir. Ce livre m’avait influencé à l’époque pour La contre-histoire de l’Internet. C’était cette même idée. Je voulais raconter l’histoire de l’Internet du côté de ceux qui l’ont fait.

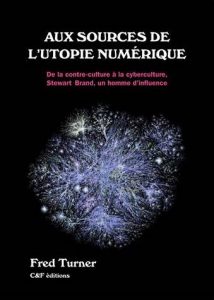

Ceux qui ont fait Internet, c’est en bonne partie des hackers. C’est pourquoi le film commençait notamment par raconter pourquoi, contrairement à ce qui est dit souvent dans les médias, Internet n’a pas été créé par l’armée américaine dans les années 60 pour résister à une bombe nucléaire soviétique. A l’époque, l’armée américaine finançait énormément de projets technologiques dont la majeure partie ont été oubliés dans les poubelles de l’histoire, sauf qu’Internet a fonctionné. Internet a été créé par des gens qui avaient un esprit de hackers, des bidouilleurs qui étaient proches de l’underground, qui connaissaient des gens qui prenaient du LSD, voire en prenaient eux-mêmes… On ne peut pas comprendre Internet si on ne comprend pas que cela vient aussi de la contre-culture.  C’est le livre Aux sources de l’utopie numérique : De la contre-culture à la cyberculture de Fred Turner, livre fondamental pour comprendre cela. Avec cette nuance qu’un certain nombre des acteurs qui faisaient partie de la contre-culture dans les années 70-80 et qui ont ensuite développé la cyberculture, même si je n’aime pas le terme, sont aujourd’hui des libertariens avec un côté anarchiste de droite. C’est assez étonnant de la part de gens qui venaient de la contre-culture et étaient plutôt gauchistes. Internet est donc la rencontre improbable entre le complexe militaro-industriel et les hippies qui prenaient du LSD. Ce n’est donc pas du tout une histoire de câbles et de tuyaux.

C’est le livre Aux sources de l’utopie numérique : De la contre-culture à la cyberculture de Fred Turner, livre fondamental pour comprendre cela. Avec cette nuance qu’un certain nombre des acteurs qui faisaient partie de la contre-culture dans les années 70-80 et qui ont ensuite développé la cyberculture, même si je n’aime pas le terme, sont aujourd’hui des libertariens avec un côté anarchiste de droite. C’est assez étonnant de la part de gens qui venaient de la contre-culture et étaient plutôt gauchistes. Internet est donc la rencontre improbable entre le complexe militaro-industriel et les hippies qui prenaient du LSD. Ce n’est donc pas du tout une histoire de câbles et de tuyaux.

Une Contre-histoire de l’Internet raconte donc cette histoire comme étant une histoire sociale plutôt que technologique ?

J’ai publié sur Owni un article, également repris sur Rue 89, où j’expliquais comment, en 92-93, avant l’arrivée du Web, quand j’étais étudiant en cinéma, je faisais comme job d’étudiant « animatrice Minitel rose ». Je me retrouvais la nuit devant quatre minitels à me faire passer pour une femme et à inventer des scénarios. Pourquoi je parle de cela, c’est parce que j’ai eu un rapport à la télématique qui m’a permis très tôt de comprendre que ces histoires d’interconnexions, de réseaux, le fait d’être devant un écran pour parler avec des gens, ce n’est pas une histoire de câbles, c’est avant tout une histoire d’êtres humains. Avant même d’avoir une connexion Internet, j’avais découvert à quel point le fait de pouvoir parler avec des gens par clavier et écran interposés permettait de libérer la parole, permettait d’entrer dans l’intimité des gens comme jamais je n’aurais pu le faire… Jamais je ne pourrai avoir de discussions aussi intimes, aussi enflammées que ce que j’ai pu avoir lorsque j’étais « animatrice Minitel rose ». Cela a été pour moi quelque chose de très important dans mon approche d’Internet. La technique, c’est un moyen. Internet, c’est quelque chose de profondément humain. Dans le web-doc qui est associé au documentaire, Une contre-histoire des internets au pluriel, j’y explique que « les Internets », c’est Internet moins les tuyaux : c’est à dire les êtres humains.

Quelle évolution peut-on voir entre le Minitel et Internet ?

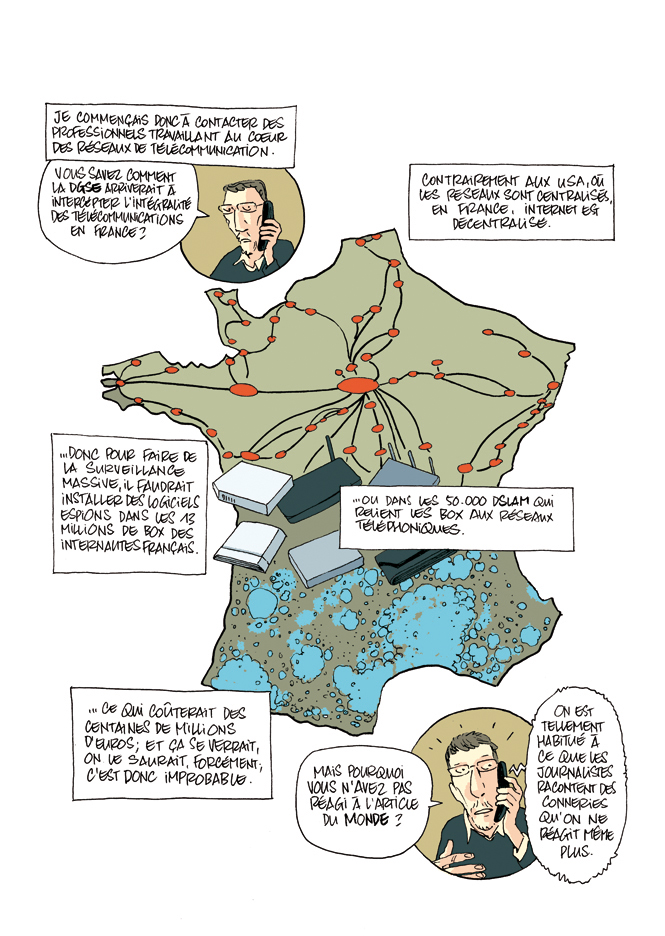

Le minitel était centralisé, internet est décentralisé, et ça change tout. La France avait fait le choix de la centralisation avec le Minitel et les Etats-Unis de la décentralisation avec TCP/IP. D’un point de vue géopolitique, le fait de décentraliser fait que tout un chacun est habilité à s’exprimer. Le fait que tout soit centralisé avec le Minitel fait que tout un chacun n’était pas habilité à s’exprimer. Quand le Minitel a été lancé en 1981, il y a eu une expérimentation à Strasbourg avec un serveur appelé Gretel. Cela permettait aux gens de pouvoir se connecter à des serveurs pour pouvoir lire de l’information, un peu comme la télévision où on est spectateur. On ne peut pas interagir avec ce qui se passe à la télévision. Comme c’était une expérimentation, les concepteurs avaient ouvert un canal de discussions qui permettait de poser des questions à l’administrateur. Il fallait bien pouvoir répondre en temps réel aux problèmes des utilisateurs du Minitel. Sauf que, assez rapidement, l’administrateur de Gretel s’est aperçu qu’une nuit, un adolescent ou quelqu’un qui se faisait passer pour un adolescent, on n’a jamais réussi à l’identifier, avait réussi à pirater le canal qui permettait de poser des questions à l’administrateur pour faire de telle sorte que les utilisateurs du Minitel puissent communiquer entre eux de façon one to one, donc de façon horizontale et non plus verticale. Les créateurs du Minitel ont laissé les gens parler entre eux et ça a donné le Minitel rose qui a été la vache à lait de France Telecom. C’est l’endroit où énormément de gens qui allaient être des pionniers d’Internet ont commencé à se faire de l’argent, le plus connu étant Xavier Niel.

C’est plus qu’une anecdote, cela relève de l’histoire. C’est fondamental pour comprendre ce que permet la télématique, ce que permet Internet. c’est quelque chose de l’ordre de l’horizontalité et non pas de la verticalité comme l’était le Minitel. On raconte ça dans le film. Jean Guisnel a écrit un livre au début des années 90, Guerres dans le cyberespace : services secrets et Internet, sur comment les services de renseignements se faisaient déjà la guerre dans le cyberespace. Il avait des contacts au sein de la police, de l’armée, des services de renseignement qui avaient accepté de répondre à ses questions mais il n’arrivait pas à parler aux gens de France Telecom. A la fin de son bouquin, il arrive enfin à décrocher un rendez-vous avec un des patrons de France Telecom qui lui dit : « Mais pourquoi est-ce que tu veux faire un bouquin sur Internet ? On va l’interdire ! » Voilà ! En 1993, France Telecom était encore dans la logique de vouloir interdire Internet pour privilégier le Minitel. C’est le côté vertical, centralisé de la culture française.

C’est plus qu’une anecdote, cela relève de l’histoire. C’est fondamental pour comprendre ce que permet la télématique, ce que permet Internet. c’est quelque chose de l’ordre de l’horizontalité et non pas de la verticalité comme l’était le Minitel. On raconte ça dans le film. Jean Guisnel a écrit un livre au début des années 90, Guerres dans le cyberespace : services secrets et Internet, sur comment les services de renseignements se faisaient déjà la guerre dans le cyberespace. Il avait des contacts au sein de la police, de l’armée, des services de renseignement qui avaient accepté de répondre à ses questions mais il n’arrivait pas à parler aux gens de France Telecom. A la fin de son bouquin, il arrive enfin à décrocher un rendez-vous avec un des patrons de France Telecom qui lui dit : « Mais pourquoi est-ce que tu veux faire un bouquin sur Internet ? On va l’interdire ! » Voilà ! En 1993, France Telecom était encore dans la logique de vouloir interdire Internet pour privilégier le Minitel. C’est le côté vertical, centralisé de la culture française.

Votre trajet personnel vous avait donc préparé à cette approche d’Internet ?

Je me souviens que, dans les années 80, il y avait plein de gens qui considéraient que les enfants qui découvraient la vie en regardant la télévision, en regardant Goldorak et Club Dorothée, ne pourraient être que décervelés. On était une génération sacrifiée parce qu’on avait grandi avec la télévision. On ne pourrait pas devenir des intellectuels. C’était tous les Bernard Pivot, les Télérama qui n’arrêtaient pas de parler de « génération sacrifiée » parce qu’on regardait la télévision. Moi, ça me révoltait, cette façon de considérer qu’on était une génération sacrifiée parce qu’on avait la télévision. Je sais que mon rapport aux écrans a commencé comme ça. Il y avait des vieux cons qui considéraient que les écrans posaient problème et il y avait des petits cons qui regardaient la télévision. Ces petits cons, ils peuvent devenir vendeurs chez MacDo comme ils peuvent devenir professeur d’université. Le fait de regarder la télévision n’est pas quelque chose de décervelant. Plus tard, quand j’ai commencé à m’intéresser au cinéma, c’était le cinéma expérimental, l’art vidéo, tout ce qui n’était pas commercial, tout ce qui sortait des sentiers battus… Donc, après, quand est arrivé Internet, ce qui m’a intéressé, c’était les hackers. J’ai compris très rapidement que les hackers n’étaient pas des pirates informatiques. Ce n’étaient pas des méchants. C’étaient eux qui avaient fabriqué Internet. Ils développaient, inventaient des nouveaux modules, de nouveaux logiciels, de nouvelles façons de penser… ça, ça m’a profondément marqué ! Donc, je viens de la contre-culture et d’un rapport contre-culturel aux écrans. Ceci explique aussi l’origine du film.

2. Julian Assange, Wikileaks et l’impact des révélations Snowden

Dans ce film, vous rencontrez un certain nombre d’acteurs essentiels de l’histoire d’Internet ? Ces rencontres ont-elles été faciles à obtenir ? Y a-t-il des intervenants que vous regrettez de ne pas avoir rencontrés ?

Il en manque bien évidemment. Le premier jour de tournage, on est allé interviewer Laurent Chemla qui n’apparaît pas au montage. C’est quelqu’un de très important dans ma compréhension d’Internet. Son livre, Confession d’un voleur, est très important pour comprendre Internet (livre disponible en ligne ici). C’est un très grand vulgarisateur, qui s’exprime très bien à l’écrit. Quand je l’ai interviewé, ça a duré une heure et demie. Une fois sorti de l’interview, Sylvain Bergère, le réalisateur du film, m’a dit : « Ecoute, Jean-Marc, tu n’as jamais fait de documentaires, mais plus jamais tu ne me fais un coup comme ça ! On a vingt-six personnes à interviewer et, généralement, un documentaire, c’est sept ou huit personnes par documentaire. Tu en as choisi vingt-six, ce n’est pas dans les standards de la télévision et si, en plus, tu me fais des interviews d’une heure et demie, moi, je ne m’en sortirai jamais au montage. » Cela a commencé comme ça, assez frontalement avec le réalisateur. Au final, on a interviewé une cinquantaine de personnes. Donc, on a doublé le nombre d’intervenants. Même si je n’ai pas fait beaucoup d’interviews d’une heure et demie, il s’est retrouvé avec 60-70 heures de rushes. C’était un boulot titanesque ! Sauf qu’il m’a remercié au final en me disant : « Il y a tellement de matière dans les interviews que tu as faites qu’on a de quoi faire un bon documentaire! »

Il en manque bien évidemment. Le premier jour de tournage, on est allé interviewer Laurent Chemla qui n’apparaît pas au montage. C’est quelqu’un de très important dans ma compréhension d’Internet. Son livre, Confession d’un voleur, est très important pour comprendre Internet (livre disponible en ligne ici). C’est un très grand vulgarisateur, qui s’exprime très bien à l’écrit. Quand je l’ai interviewé, ça a duré une heure et demie. Une fois sorti de l’interview, Sylvain Bergère, le réalisateur du film, m’a dit : « Ecoute, Jean-Marc, tu n’as jamais fait de documentaires, mais plus jamais tu ne me fais un coup comme ça ! On a vingt-six personnes à interviewer et, généralement, un documentaire, c’est sept ou huit personnes par documentaire. Tu en as choisi vingt-six, ce n’est pas dans les standards de la télévision et si, en plus, tu me fais des interviews d’une heure et demie, moi, je ne m’en sortirai jamais au montage. » Cela a commencé comme ça, assez frontalement avec le réalisateur. Au final, on a interviewé une cinquantaine de personnes. Donc, on a doublé le nombre d’intervenants. Même si je n’ai pas fait beaucoup d’interviews d’une heure et demie, il s’est retrouvé avec 60-70 heures de rushes. C’était un boulot titanesque ! Sauf qu’il m’a remercié au final en me disant : « Il y a tellement de matière dans les interviews que tu as faites qu’on a de quoi faire un bon documentaire! »

Pour moi, c’était évident que si je voulais parler d’Internet, il fallait que j’aille voir ceux qui sont considérés comme de grandes figures de cette contre-culture. Je ne sais même pas finalement si c’est de la contre-culture ou si c’est de la culture. Pour moi, c’est la culture d’Internet : on a fait la contre-histoire, mais, en fait, c’est l’histoire d’Internet. Si j’ai appelé le film « contre-histoire », c’est parce qu’il y a un côté contre-culturel. Ce qui était étonnant pour moi, c’était de voir que, lorsque le film a été diffusé en mai 2013, les gens que j’ai filmés étaient perçus comme étant du côté de la contre-culture, du côté des protestataires. Il se trouve qu’il y a eu les révélations Snowden à partir de juin 2013. Les révélations Snowden ont changé le statut d’une partie des gens que j’ai interviewés. Avant Snowden, ils faisaient partie du problème, car ils râlaient contre l’état qui mettait trop de surveillance et pas assez de liberté. Or, depuis les révélations Snowden, les gens que j’ai interviewés sont maintenant perçus comme étant du côté de la solution. Ils sont ceux qui apportent des solutions aux problèmes de la surveillance et des atteintes aux libertés sur Internet. Si le documentaire avait été diffusé après les révélations de l’affaire Snowden, j’aurais dû refaire le montage probablement, voire ajouter des interviews. Cela aurait donné un film complètement autre. Avant Snowden, si on regarde l’e-G8 qu’avait organisé Nicolas Sarkozy, les acteurs essentiels de l’Internet, c’était ce qu’on appelait la net-économie, les start-ups, Facebook, la French Tech… : les acteurs de l’économie capitalistique d’Internet. Pour moi, ce n’est pas ça. Internet : ce n’est pas une question de technologie, ce n’est pas une question d’économie. Internet, c’est quelque chose qui relève beaucoup plus de la sociologie et c’est de la politique !

Vous avez notamment réussi à interviewer Julian Assange pour votre film ?

C’était la personne la plus compliquée à interviewer pour des raisons faciles à comprendre. Il était enfermé dans l’ambassade d’Equateur. Il ne pouvait pas sortir. Lui, il n’est pas parano. Il est surveillé en permanence ! Je ne sais plus combien de millions sont dépensés chaque année pour surveiller l’ambassade d’Equateur à Londres. C’est une High Value Target. Donc, ça a été très compliqué pour obtenir un rendez-vous avec lui. Quand j’ai obtenu ce rendez-vous, il m’a accordé initialement vingt minutes. Il est arrivé avec une demi-heure de retard et était très énervé. Il m’a dit : « Je vous donne un quart d’heure ! » J’ai commencé à lui poser des questions et, au bout d’une heure et demie, j’ai dû lui demander d’arrêter l’interview parce que j’allais rater mon train ! Il voulait que je reste pour continuer à lui poser des questions. J’étais assez honoré de voir que quelqu’un qui était énervé au départ m’accordait finalement une heure et demie d’interview. ça montrait que les questions que je posais l’intéressaient.

C’était la personne la plus compliquée à interviewer pour des raisons faciles à comprendre. Il était enfermé dans l’ambassade d’Equateur. Il ne pouvait pas sortir. Lui, il n’est pas parano. Il est surveillé en permanence ! Je ne sais plus combien de millions sont dépensés chaque année pour surveiller l’ambassade d’Equateur à Londres. C’est une High Value Target. Donc, ça a été très compliqué pour obtenir un rendez-vous avec lui. Quand j’ai obtenu ce rendez-vous, il m’a accordé initialement vingt minutes. Il est arrivé avec une demi-heure de retard et était très énervé. Il m’a dit : « Je vous donne un quart d’heure ! » J’ai commencé à lui poser des questions et, au bout d’une heure et demie, j’ai dû lui demander d’arrêter l’interview parce que j’allais rater mon train ! Il voulait que je reste pour continuer à lui poser des questions. J’étais assez honoré de voir que quelqu’un qui était énervé au départ m’accordait finalement une heure et demie d’interview. ça montrait que les questions que je posais l’intéressaient.

Ce que j’ai essayé de faire, c’est d’accoucher la parole de ces gens qui, pour une fois, étaient interviewés par quelqu’un qui comprenait leur combat. La majeure partie du temps, quand Assange et d’autres sont interviewés, ils sont interviewés par des gens qui ne connaissent pas ce dont ils parlent. C’est un travers majeur du journalisme que je vis au quotidien. énormément de journalistes parlent de choses qu’ils ne connaissent pas. C’est ce à quoi je suis confronté depuis deux ans avec la Loi renseignement ou avec Snowden. J’ai été interviewé un grand nombre de fois et la meilleure interview à laquelle j’ai été soumis, c’est lorsque j’ai été interviewé par un journal qui s’appelle Article 11 : le journaliste a réussi à me faire dire des choses auxquelles je n’avais jamais pensé, que je n’avais encore jamais réussi à formuler de cette façon–là.

3. De la surveillance de masse à la paranoïa généralisée

Vous articulez l’histoire d’internet autour de quelques axes dont celui de la liberté (d’expression, de création, de partage) et celui du contrôle et de la surveillance. Depuis la sortie de votre film, vous venez de l’évoquer avec les révélations Snowden, ce sujet a-t-il fait l’objet d’une évolution ?

J’ai fait deux conférences l’année dernière et l’année d’avant à Pas Sage en Seine, un festival de hackers à Paris. On peut en trouver la retranscription sur mon blog pour Le Monde. J’avais intitulé cette conférence De la surveillance de masse à la paranoïa généralisée. Je vais essayer de résumer. Avant les révélations Snowden, des gens comme moi ou ceux que j’ai interviewés, on passait pour des contestataires, pour des paranos, éventuellement pour des gauchistes… Depuis les révélations Snowden, tout le monde est devenu parano. Paradoxalement, je me retrouve de plus en plus à essayer d’expliquer aux gens que non, la NSA ne surveille pas l’intégralité de la population ! Il faut arrêter les délires ! Je suis consterné par le niveau de débat, notamment dans les médias et, bien évidemment, dans la classe politique. Ils en parlent comme si la NSA, la DGSE, les services de renseignements, surveillaient l’intégralité des internautes. On parle beaucoup de la « surveillance de masse ». C’est la nouvelle expression en vogue depuis les révélations Snowden. Moi, je ne suis pas d’accord avec cette expression. Il y a des systèmes de collecte d’informations de masse qui ont été mis en place par les services de renseignement. Cela ne veut pas dire que c’est de la surveillance de masse. L’expression « surveillance de masse » laisserait entendre que les services de renseignement surveilleraient toute la population, ce qui n’est absolument pas le cas. Matériellement parlant, c’est juste impossible ! Pour l’instant, je fais un module vidéo pour France 4 qui s’appelle What the Fact qui devrait sortir dans les semaines qui viennent. Il expliquera que le volume de données échangées chaque jour, que ce soit en France ou dans le monde, est tellement important qu’il est financièrement, humainement, matériellement, techniquement impossible de tout surveiller. De plus, ce n’est pas ce que réclament les services de renseignements. Ils ont autre chose à faire. Il y a suffisamment de menaces comme ça pour ne pas vouloir surveiller l’intégralité de la population.

Dans cet avant et cet après Snowden, paradoxalement, moi qui travaille depuis une quinzaine d’années sur les questions de surveillance et donc sur les services de renseignement, je me retrouve plus proche de gens qui travaillent ou ont travaillé dans les services de renseignement que du côté d’un certain nombre de défenseurs des libertés. C’est assez paradoxal puisque je suis plutôt pote avec les gens de la Quadrature du Net et qu’on perçoit, je pense, les prises de positions politiques que je peux avoir au regard du documentaire Une contre-histoire de l’Internet. Paradoxalement, les révélations Snowden ont provoqué quelque chose de très bien : les questions de liberté, de vie privée, de sécurité informatique ne sont plus marginalisées. Elles sont vraiment prises en compte. De plus en plus de trafic est chiffré grâce à Apple, à WhatsApp, à Facebook, à Google qui chiffrent maintenant leurs communications. De plus en plus d’internautes apprennent à chiffrer leurs communications. C’est le côté positif de Snowden. Le côté négatif, c’est que de plus en plus de gens sont complètement paranos. Au lieu de comprendre ce que font les services de renseignement, ils en ont peur. Je n’ai pas peur des services de renseignements. Je n’ai pas peur de la surveillance.

Quelles nuances faites-vous entre « surveillance » de masse et « collecte » de masse ?

Parce que Snowden et Greenwald ont un agenda politique, la notion de surveillance de masse s’est substituée à la notion de collecte de masse. On a un débat sémantique avec des gens de la Quadrature depuis maintenant deux ans. Ils considèrent qu’à partir du moment où il y a de la collecte de masse, cela relève de la surveillance de masse, même s’il n’y a pas d’êtres humains qui regardent les données collectées. Il y a de fait des systèmes de « collecte de masse », mais ça ne veut pas dire que les services de renseignement surveillent tout le monde. Si on regarde la Loi renseignement en France, les dispositifs de collecte de masse utilisés par la DGSE n’ont pas le « droit », pour le coup, de surveiller des Français : les identifiants rattachés au territoire national doivent en effet être écrasés, sauf s’ils figurent dans les « cibles » préalablement identifiées par les services de renseignement.. Si jamais il y a un identifiant rattaché au territoire national, que ce soit un numéro de téléphone, une adresse mail ou une adresse IP, ils n’ont légalement pas le droit de regarder les données ou les métadonnées. Toute surveillance d’un Français doit être ciblée, validée par Matignon, après avis de la CNCTR qui est la commission de contrôle des techniques de renseignement. Pour un certain nombre de thuriféraires de Snowden, ils considèrent qu’à partir du moment où les données sont collectées et traitées par des algorithmes, quand bien même il n’y a pas de traitement humain derrière, ça relève de la surveillance. Je ne suis pas d’accord avec ça. On parle beaucoup, depuis Snowden, de « surveillance de masse », mais les systèmes de « collecte de masse » des services de renseignement ne permettent, -ni ne visent à-, surveiller massivement « tout le monde »… à l’exception des pays où les Etats-Unis (voire la France ?) « font » la guerre, comme la Syrie ou l’Afghanistan, par exemple.

Cette surveillance ou collecte de données est-elle efficace ?

Je vais être concret. La NSA, combien d’attentats terroristes a-t-elle déjoués grâce à ce système de collecte de masse ? Concrètement, quand la question a été posée par le parlement américain à la NSA, celle-ci a commencé par répondre 80 attentats. Ensuite, quand les parlementaires ont posé la question : « Mais des attentats où ? », la NSA a reconnu des dizaines d’attentats qui auraient été déjoués dans d’autres pays que les Etats Unis. Concrètement, sur le territoire américain, sachant qu’il y a des collectes de masse des métadonnées des Américains (c’est une des révélations Snowden), il y a une seule personne qui a été condamnée à quinze ans de prison. C’était un réfugié somalien qui vivait aux Etats Unis depuis des années et qui, comme beaucoup de réfugiés, renvoyait de l’argent à son pays pour fabriquer des écoles, des dispensaires, pour aider l’économie locale. Il se trouve que son village, un jour, a été conquis par la milice Al-Shabbaab considérée comme une milice terroriste par les Etats-Unis. Grâce à la surveillance des métadonnées, la NSA a identifié qu’il y avait quelqu’un sur le territoire américain qui communiquait avec quelqu’un sur un territoire contrôlé par Al-Shabbaab. Ils l’ont accusé d’avoir envoyé 3.500 dollars. J’avais fait une enquête pour Arrêt sur images là-dessus il y a deux ans. Donc, pour avoir envoyé cet argent, il a été condamné à quinze ans de prison. Il n’a jamais été démontré que le réfugié somalien en question savait qu’il envoyait de l’argent à des gens qui étaient sous la domination d’une milice terroriste. Il n’a jamais été démontré donc qu’il finançait le terrorisme. Il n’en n’a pas moins été condamné. C’est la seule condamnation sur le territoire américain basée sur la surveillance des métadonnées. Est-ce que c’est efficace ? Clairement, non !

Et en France ?

Je ne sais pas ce que font les services de renseignement. Je ne suis pas dans le secret des Dieux. Ce que je sais, c’est qu’on parle de 3000 profils menaçants en France. Là, je ne parle que du djihadisme. Ils sont 3500 à la DGSI, le contre-espionnage. Pour surveiller quelqu’un H24, il faut entre 10 et 20 personnes. Or, la DGSI ne fait pas que de la lutte contre le terrorisme islamiste : elle a beaucoup de travail contre la criminalité organisée, contre l’espionnage industriel, etc. Donc, ils sont tellement débordés par toutes les tâches qui leur sont confiées que c’est complètement invraisemblable de laisser entendre que les services de renseignements français surveilleraient massivement les Français. Ils ont franchement autre chose à faire. Cela me semble évident. Les rapports de l’autorité de contrôle des services de renseignement révèlent qu’en moyenne par an, ce sont 6000 cibles qui sont écoutées. Cela peut être une cellule islamiste de plusieurs personnes, cela peut être une personne avec dix téléphones portables… C’est en moyenne 6000. Il y a un quota de 2800 interceptions simultanées qui est attribué par Matignon. Il n’a jamais été dépassé, signe que les services n’ont donc pas besoin de pouvoir surveiller plus de 2800 personnes en simultané, et qu’il n’y a donc pas tant de « menaces » que cela. On a eu l’année dernière avec la Loi renseignement énormément de gens qui disaient qu’avec les boites noires, la Loi renseignement allait surveiller tous les Français. Ce que je sais moi, c’est que le quota de 2800 interceptions simultanées n’a jamais été atteint. Donc il n’y a pas un besoin si impérieux que ça des services de renseignement de surveiller massivement les gens. C’est quelque chose que j’ai découvert depuis les révélations Snowden. Je ne vous l’aurais pas dit si vous m’aviez interviewé en mai 2013. Quand les révélations Snowden sont arrivées, plein de journalistes n’y connaissaient rien en techniques de renseignements, NSA et compagnie… Je travaillais depuis longtemps là-dessus. J’ai donc commencé à suivre les révélations Snowden de près et à m’intéresser à ce que faisaient les services de renseignement en France.

Les services de renseignement ne peuvent pas surveiller « tout le monde ». Une part de votre travail repose cependant sur la nécessité de protéger ses données. Pourquoi ?

Sauf dans quelques pays en guerre avec les USA, ainsi que dans des dictatures, la « surveillance de masse » (aka surveiller tout le monde) est quasi-impossible et ne servirait pas à grand chose. Les services ont autre chose à faire.

A contrario, comme lesdits services ne s’en arrogent pas moins le droit et la possibilité de pouvoir surveiller tous ceux qui communiquent avec ceux qui communiquent avec leurs « cibles » : n’importe qui peut être surveillé, même s’il n’a « rien à cacher ». La question, le problème, n’est pas de savoir si on a « rien à cacher ». On ne peut plus se réfugier derrière cet argument. Aujourd’hui, on est tous à +- 6 niveaux de séparation de n’importe quel autre être humain et, si on est sur Facebook, à +- 3.5 niveaux de séparation de n’importe quel autre utilisateur de Facebook. Or, la NSA et ses partenaires anglo-saxons ont conceptualisé la notion de « three hops« , à savoir le fait de pouvoir surveiller ceux qui communiquent avec ceux qui communiquent avec leurs « cibles ». Un ancien patron de la NSA avait ainsi expliqué que « les méta-données tuent », expliquant que la CIA avait tué un terroriste, via un drone, après que la NSA ait réussi à surveiller les mails d’une amie de sa femme, et donc de remonter jusqu’à lui. Ladite amie n’était pas terroriste et n’avait peut-être « rien à cacher »… mais c’est en la surveillant que la NSA est remontée jusqu’à la femme du terroriste (l’histoire ne dit pas si sa femme a aussi été tuée dans l’attaque du drone).

En France, le Parlement a adopté, en juillet dernier, la possibilité de recueillir en temps réel des données de connexion d’une personne « préalablement identifiée (comme) susceptible d’être en lien avec une menace »… Donc, ce n’est pas parce que la surveillance de masse ubiquitaire me semble plus constituer un fantasme paranoïaque. Comme dit précédemment, les services de renseignement des pays démocratiques ne peuvent pas (légalement, techniquement, financièrement… sans parler de la masse salariale que cela devrait représenter) surveiller « tout le monde ». De plus, ils doivent obtenir une autorisation pour espionner toute personne se trouvant sur leur territoire national même et y compris s’il s’agit d’un étranger, a fortiori s’il s’agit d’un ressortissant. A contrario, ils font ce qu’ils veulent/peuvent pour ce qui est de la surveillance des étrangers… à l’étranger. Ils peuvent, légalement, financièrement et techniquement, surveiller « n’importe qui », et sont de plus en plus amenés à surveiller des gens qui n’ont « rien à cacher », mais qui sont en contact avec des gens qui sont en contact avec leurs « cibles »… Ce pourquoi il faut aussi apprendre à protéger ses données et communications, nonobstant le fait que « n’importe qui » peut donc aussi être surveillé par des services de renseignement étranger : le simple fait de communiquer avec le secrétaire particulier d’un PDG du CAC40, des employés d’une start-up prometteuse, d’un cabinet ministériel, d’un syndicat, d’un parti politique ou d’une ONG, même et y compris si vous n’évoquez jamais leurs vies professionnelles, pourraient vous valoir d’être espionné.

Internet en général, et l’informatique en particulier, n’ont pas été conçus pour sécuriser nos données et télécommunications. Ce pour quoi il faut apprendre à se protéger, nonobstant le fait que vous risquez par ailleurs et bien plus d’être surveillé, voire espionné, par votre conjoint, vos collègues et supérieurs qui peuvent physiquement accéder à vos ordis et téléphones portables, des concurrents de votre employeur ou encore et surtout par des « pirates informatiques » en quête notamment de vos numéros de login ou votre mot de passe de carte bancaire… Les services de renseignement ne sont pas, loin de là, la principale « menace » à laquelle doit faire face les internautes. Ils en constitueraient même la portion congrue. La surveillance est aussi un bizness. Même si vous n’avez « rien à cacher », même si vous pensez ne communiquer qu’avec des gens qui ne pourraient être considérés comme des « cibles » par des espions oeuvrant pour un pays ou des barbouzes travaillant pour des entreprises privées ou publiques, la majeure partie des gens qui sont placés sous surveillance, voire espionnés, le sont par des « proches » ayant un accès « physique » à leurs ordinateurs et/ou smartphones.

En matière de sécurité informatique, et de protection de la vie privée, le problème, ce n’est pas tant la NSA et ses soi disant super-pouvoirs surestimés que le fait que, par défaut, nos données ne sont pas sécurisées. Ce pourquoi il faut apprendre à se protéger. La sécurité informatique est un métier, somme toute très complexe et donc compliqué. Edward Snowden, ou encore les récentes révélations des « Shadow Brokers« , ont démontré que même la NSA, la plus puissante des agences de renseignement technique, pouvait être espionnée.

En attendant, et par défaut, partez du principe que vous êtes « à poil », et que ce que vous faites sur l’internet y circule « en clair » même si plus de 80% des requêtes Google sont par ailleurs « chiffrées » et donc, a priori, indéchiffrables, y compris par la NSA. En terme de « parano » post-Snowden et de « modèle de menace » (aka « Qui pourrait vouloir vous espionner ? »), la NSA est l’ »idiot utile » de la sécurité informatique. Donc, partez du principe qu’il y a bien plus de « risques » que vous soyez surveillé, voire espionné, par des gens qui vous connaissent et qui disposent d’un accès physique à votre ordinateur ou smartphone que par la NSA et Cie…

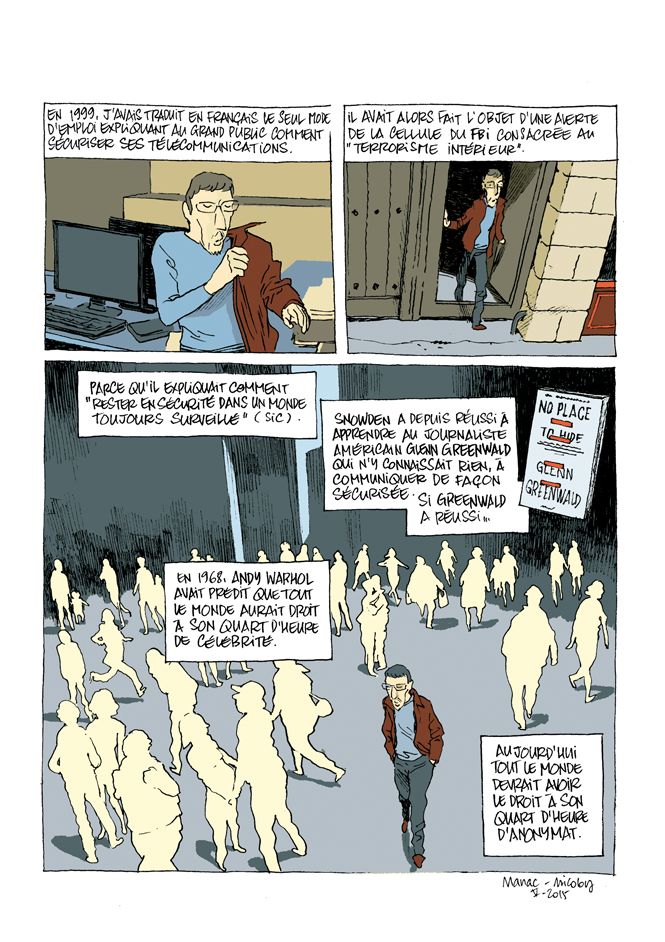

J’avais développé un concept qui a été repris par Reporters Sans Frontières dans son guide de sécurité informatique. C’est la notion de quart d’heure d’anonymat. Si j’ai quelque chose que je veux faire sur Internet, mais que je ne veux pas laisser de traces ou que je ne veux pas que ce soit exploité par Google, par Facebook, par des régies publicitaires, par des services de renseignements…, c’est à moi de m’en donner les moyens et d’utiliser des systèmes de protection de la vie privée, de sécurité informatique. C’est la référence à la phrase de Warhol. En 68, il avait déclaré : « A l’avenir, tout le monde aura le droit à son quart d’heure de célébrité ». Avec la télé-réalité dans les années 90 et 2000, on y a eu droit. Ce n’était encore qu’une infime partie de la population. Maintenant, avec Internet, c’est tout un chacun qui peut avoir son quart d’heure de célébrité. La question aujourd’hui, à l’ère d’Internet, à l’ère de la transparence et à l’ère de la surveillance, c’est : « Comment avoir son quart d’heure d’anonymat ? »

4. Comment les médias parlent d’Internet ?

D’où vient cette incompréhension de beaucoup de médias devant Internet ?

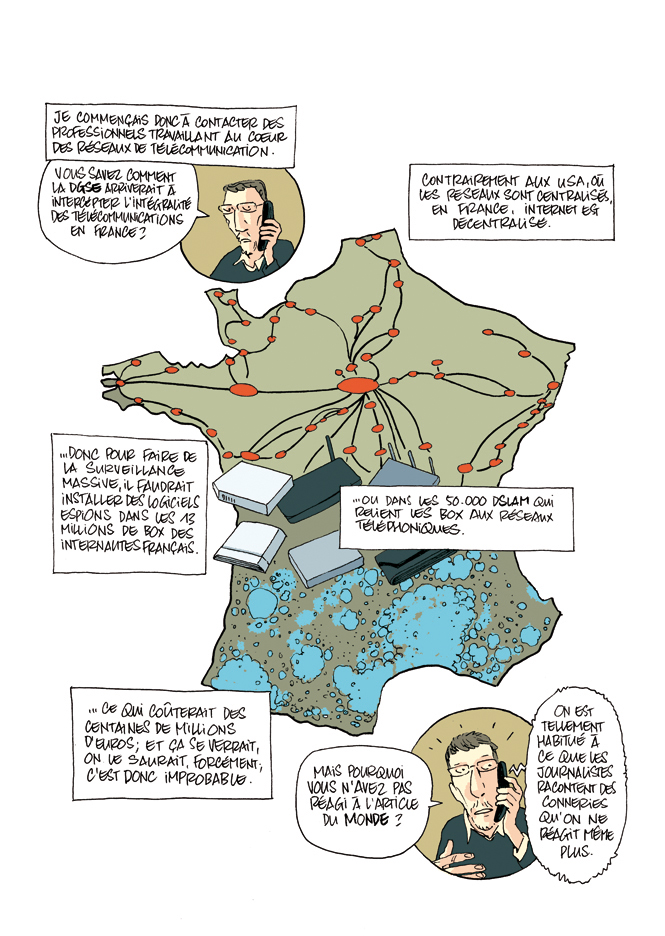

Il y a une anecdote qui n’est pas dans le film et que je raconte dans une BD sortie l’an dernier intitulée Grandes oreilles et bras cassés. Dans la foulée des révélations Snowden, le Monde a titré en une que la DGSE surveillait les communications de tous les Français. J’ai essayé de savoir comment ce serait possible techniquement, financièrement et légalement de surveiller tous les Français. Il faudrait mettre des boites noires dans 50.000 DSLAM. Quand j’ai découvert que c’était impossible techniquement, humainement, financièrement et légalement, j’ai demandé aux ingénieurs informaticiens qui travaillaient au coeur des réseaux Internet pourquoi ils n’avaient pas réagi à l’article du Monde. Ils m’ont répondu : « On est tellement habitué à ce que les journalistes racontent n’importe quoi sur Internet qu’on ne réagit même plus ». C’est catastrophique. Internet est de plus en plus au coeur de nos vies. Le problème, c’est qu’un nombre de plus en plus important de gens qui travaillent au coeur d’Internet ne réagissent même plus quand les médias racontent des conneries. C’est un vrai problème de déficit démocratique et géopolitique de compréhension de ce qu’est Internet. Ce que j’ai essayé de faire avec Une contre-histoire de l’Internet, c’était ça : moi qui connais un petit peu la question, je suis allé voir des gens qui connaissent bien la question pour qu’on en parle. Je pense que la réussite du film, c’est d’aller au-delà des propos de comptoir pour essayer de parler vraiment de ce que c’est Internet (#oupas).

Il y a une anecdote qui n’est pas dans le film et que je raconte dans une BD sortie l’an dernier intitulée Grandes oreilles et bras cassés. Dans la foulée des révélations Snowden, le Monde a titré en une que la DGSE surveillait les communications de tous les Français. J’ai essayé de savoir comment ce serait possible techniquement, financièrement et légalement de surveiller tous les Français. Il faudrait mettre des boites noires dans 50.000 DSLAM. Quand j’ai découvert que c’était impossible techniquement, humainement, financièrement et légalement, j’ai demandé aux ingénieurs informaticiens qui travaillaient au coeur des réseaux Internet pourquoi ils n’avaient pas réagi à l’article du Monde. Ils m’ont répondu : « On est tellement habitué à ce que les journalistes racontent n’importe quoi sur Internet qu’on ne réagit même plus ». C’est catastrophique. Internet est de plus en plus au coeur de nos vies. Le problème, c’est qu’un nombre de plus en plus important de gens qui travaillent au coeur d’Internet ne réagissent même plus quand les médias racontent des conneries. C’est un vrai problème de déficit démocratique et géopolitique de compréhension de ce qu’est Internet. Ce que j’ai essayé de faire avec Une contre-histoire de l’Internet, c’était ça : moi qui connais un petit peu la question, je suis allé voir des gens qui connaissent bien la question pour qu’on en parle. Je pense que la réussite du film, c’est d’aller au-delà des propos de comptoir pour essayer de parler vraiment de ce que c’est Internet (#oupas).

Votre film développe différentes formes de détournements politiques d’Internet dont l’hacktivisme rencontré durant le Printemps arabe. Celui-ci serait-il encore possible aujourd’hui ?

Oui, mais ça prend de nouvelles formes. Durant le Printemps arabe, je me souviens que l’Egypte, à un moment, avait coupé Internet pour éviter que les gens ne se rassemblent grâce à Facebook. Cela n’a pas empêché Facebook d’être massivement utilisé durant le Printemps arabe. Aujourd’hui, on a de plus en plus de pays qui censurent Internet. WhatsApp a été censuré au Brésil. Il y a de plus en plus de censures et, en face, on a de plus en plus de réponses. Aujourd’hui, on parle beaucoup de Telegram parce que Telegram aurait été utilisé par le terroriste qui a égorgé un prêtre il y a quelques jours. Il y a eu une enquête dans L’Express le 14 juillet dernier qui montrait que de plus en plus de responsables politiques utilisent eux aussi Telegram. Pour l’instant, je n’arrête pas d’être interviewé par la presse autour de Telegram. J’explique que les terroristes sont des internautes comme les autres. Depuis les révélations Snowden, de plus en plus d’internautes chiffrent leurs communications. Il y a 100 millions d’utilisateurs de Telegram et, dans les 100 millions d’utilisateurs, il y a des défenseurs des libertés, beaucoup de simples particuliers, beaucoup de politiques et puis il y a quelques terroristes. Donc, on associe Telegram aux terroristes sauf que les 100 millions d’utilisateurs ne sont pas 100 millions de terroristes. Je fais souvent cette analogie : la totalité des terroristes qui se réclament du djihadisme se réclament d’une interprétation de l’Islam, mais il serait absurde, contre-productif et insultant de dire pour autant que tous les musulmans sont des terroristes. Sur les hackers ou sur les gens qui, sans être des hackers, utilisent des logiciels de chiffrement, c’est la même chose : ce n’est pas parce qu’ils sont des terroristes ou des délinquants. Ce sont juste des gens qui veulent protéger leur vie privée. Tout simplement.

Pour revenir au Printemps arabe, c’était les réseaux sociaux : à savoir de la communication publique. Aujourd’hui, de plus en plus, ce sont les moyens de communication chiffrée qui sont utilisés. Il n’y a pas très longtemps, j’ai contribué à un documentaire avec un réalisateur israélien sur le Dark Web. Ce qui était très intéressant pour moi, c’est qu’il a notamment interviewé une journaliste en Egypte qui rigolait en découvrant que la majeure partie du temps, dans les médias occidentaux, quand on parle du Dark Web ou de Tor, on parle des gens qui les utilisent pour acheter de la drogue ou des pédophiles. Elle nous disait : « C’est hallucinant ! Chez nous, en Egypte, la majeure partie des gens qui utilisent le Dark Web et Tor, c’est parce que ce sont des gens de la communauté LGBT ou des démocrates… Parce qu’on sait qu’en Egypte, les communications sont surveillées. Donc, on passe par Tor et on va sur le Dark Web pour défendre nos libertés ».

Je me rappelle du premier reportage qui avait été consacré à Facebook sur France 2 dont le pitch était : « Facebook permet à des adolescentes de montrer leurs décolletés et d’acheter du cannabis ! » C’est ainsi que la télévision française a commencé à présenter Facebook ! A la fin des années 90, Françoise Giroud, une des grandes figures du journalisme en France, avait dit qu’Internet était un danger public parce que n’importe qui peut dire n’importe quoi. C’était hallucinant, sinon scandaleux ! Alors, la démocratie, c’est aussi un danger public puisque n’importe qui peut voter pour n’importe qui. Soit on accepte le jeu de la démocratie, soit on le refuse. J’ai très rapidement perçu Internet comme étant quelque chose d’émancipateur et cela a été confirmé dans les faits. Interdire Facebook, c’est le voir remplacé par Tor et si on interdit Tor, les gens passeront par d’autres canaux. La révolution est en marche et je pense qu’on ne pourra plus l’enrayer. Le Printemps arabe a démontré que Facebook ne servait pas qu’à montrer son cul, mais que cela allait bien au-delà : Facebook était réellement quelque chose qui changeait la donne d’un point de vue politique et d’un point de vue sociétal. Aujourd’hui, il y a de plus en plus de systèmes de surveillance, donc les gens vont de plus en plus vers le Dark Web et vers le chiffrement. ça n’en finira jamais et c’est toujours nous, les défenseurs des libertés, qui gagnerons à la fin.

En 1997, dans son ouvrage Cyberculture, le philosophe Pierre Lévy considérait qu’Internet incarnait certains idéaux révolutionnaires des Lumières.

Je vous parlais tout à l’heure de Laurent Chemla. Une des raisons pour laquelle il a été très important pour moi, c’est que dans son livre, Je suis un voleur, il explique qu’en 1789, la Déclaration universelle des droits de l’homme, a inscrit la liberté d’expression comme étant un des socles fondateurs de la démocratie. Jusqu’à Internet, les seules personnes qui pouvaient faire valoir cette liberté d’expression, c’était les gens qui avaient accès aux médias. Or les gens qui avaient accès aux médias, c’étaient des artistes, des intellectuels, des hommes politiques, des gens qui gagnent beaucoup d’argent… C’était une forme d’élite. Ce qu’Internet a changé, c’est que tout le monde a accès à la liberté d’expression. Tout le monde peut enfin s’exprimer et être entendu. Des exemples, on en a pléthore. Internet est la concrétisation d’une promesse qui date de 1789, mais qui, jusqu’à Internet, était restée virtuelle. Paradoxalement, Internet concrétise un droit de l’homme qui était virtuel avant Internet. J’emploie le mot « virtuel » à escient au sens où énormément de gens disent qu’Internet est un monde virtuel, ce qui pour moi est complètement faux. Ce n’est pas un monde virtuel ! Au contraire, c’est on ne peut plus réel : il n’y a jamais eu autant de gens qui se parlent ! Il n’y a jamais eu autant de gens qui lisent et s’informent et qui prennent la parole pour s’exprimer ! Alors après, oui, il y en a plein qui disent des conneries ou qui disent des choses avec lesquelles on n’est pas d’accord. Là, on en revient à Voltaire : « Je ne suis pas d’accord avec vous, mais je me battrai pour que vous ayez le droit de le dire ».

5. Diffuser, enseigner la contre-histoire de l’Internet

Comment avez-vous envisagé la réception de votre film ? Avez-vous eu l’occasion de participer à des projections suivies d’échanges avec le public ? Quelles étaient les réactions ? J’ai le sentiment que beaucoup de jeunes gens ou d’adultes ne perçoivent pas ces enjeux liés à Internet.

Je n’ai pas fait énormément de projections-débats, mais j’ai le même sentiment que vous : la majeure partie des gens ne comprennent pas les tenants géopolitiques d’Internet. Le film aide à les comprendre. Je me souviens d’un texte brillant, il y a quelques années, de Jean-Noël Lafargue, un universitaire français. Il avait écrit dans Libération sur le fait que la génération Y, qui a grandi avec des tablettes, des smartphones et des ordinateurs, est à tort perçue comme étant des hackers. La génération d’avant présume que, comme ces jeunes ont grandi avec un ordinateur dans la main, ce sont de brillants informaticiens capables de casser Internet. C’est complètement faux ! Ceux qui ont grandi avec un smartphone dans la main savent appuyer sur des boutons, mais ils ne savent pas ce que ça veut dire ! Ils ne savent pas comment ça fonctionne. Quand j’ai commencé à me connecter à Internet dans les années 90, il fallait écrire du code HTML pour faire des pages web. Aujourd’hui, on fait des blogs, on va sur les réseaux sociaux et on n’a pas besoin de connaître du HTML. Donc, les pionniers de l’Internet ont dû mettre la main dans le code. Je pense qu’on ne peut pas comprendre Internet si on ne comprend pas un minimum le code. Or il y a très peu de gens dans la génération Y qui savent ce qu’est le code source d’une page web ou qui ont commencé à apprendre à coder.

La meilleure réponse que je peux vous donner quant à la réception du film, c’est que j’ai été très agréablement surpris le soir de la diffusion en suivant les réactions des gens sur Twitter. Le meilleur compliment qu’on a pu me faire, c’était des hackers, des geeks, qui me remerciaient en me disant : « Enfin, je vais pouvoir expliquer à mes parents qui je suis ! » C’était un très beau compliment parce que j’arrivais à faire le lien dans le film entre des hackers, des geeks, des gens qui comprennent le code, qui comprennent les tenants géopolitiques d’Internet et un public qui ne le comprend pas. Il n’y avait pas vraiment eu de film auparavant qui permettait d’expliquer au grand public ce pourquoi on défend les libertés sur Internet. Je ne m’attendais pas à ça. Je n’y avais pas pensé !

N’y a-t-il pas un paradoxe dans le fait qu’Internet soit aujourd’hui le principal média utilisé et qu’il ne fait pas l’objet d’un enseignement spécifique alors que le cinéma ou la télévision ont pu être introduits dans le cursus des lycées ?

Cela commence à se faire. Je ne suis pas spécialiste de l’enseignement donc je ne sais pas vous dire jusqu’où va cette éducation au média. à l’époque où j’ai fait le film, il y avait eu la fameuse loi française Création et Internet qui a produit Hadopi. Cette loi visait à réprimer le téléchargement de fichiers. Un amendement avait été adopté au parlement qui prévoyait une sensibilisation aux dangers d’Internet. Il s’agissait d’expliquer aux adolescents de ne pas faire ci ou ça sur Internet pour ne pas tomber sur un pédophile ou de ne pas télécharger et voler le pain des artistes. A l’époque, l’essentiel de la sensibilisation à Internet, c’était un peu comme si on faisait un cours d’éducation sexuelle et qu’on ne parlait que de la syphilis et du sida. C’est-à-dire créer un climat anxiogène où Internet fait peur, ce qui est complètement contre-productif. Bien évidemment, quand quelqu’un vient devant un adolescent en lui disant de ne pas faire quelque chose, que va faire l’adolescent ? En règle générale, il va faire ce qu’il ne faut pas faire car ça peut être tentant.

Ce que je vois poindre depuis un ou deux ans, c’est de plus en plus d’enseignants qui, dans le cadre de leurs cours, font des sensibilisations concernant les rumeurs et les théories de la conspiration. Les théories de la conspiration quand je suis arrivé sur Internet à la fin des années 90, c’était les Illuminatis, les Chemtrails et tout ce qu’on a vu après le 11 Septembre… C’était de petites communautés, mais ça me faisait déjà un peu peur parce que je voyais que de plus en plus de gens étaient sensibilisés à ça. Aujourd’hui, c’est catastrophique ! Aujourd’hui, c’est dans les cours des collèges qu’on parle des illuminatis et c’est massif ! Je ne sais pas comment cela se passe en Belgique mais les théories de la conspiration ont vraiment conquis les adolescents et pas que les adolescents d’ailleurs. Donc, de plus en plus de professeurs aujourd’hui font des cours ou des séminaires de sensibilisation pour expliquer comment interpréter une rumeur, un complot et comment les combattre. J’ai l’impression qu’aujourd’hui l’enseignement à Internet passe par ça.

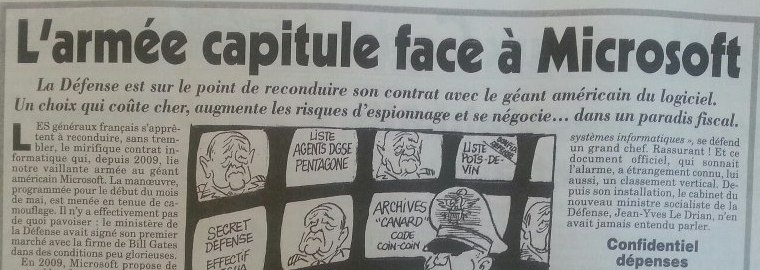

Maintenant, est-ce qu’il y a une volonté politique du côté de l’éducation nationale de faire des cours d’éducation au média telle que vous l’entendez : comprendre la géopolitique d’Internet ? Non ! A ma connaissance, il n’y a pas de volonté du gouvernement d’expliquer comment fonctionne Internet. J’en veux pour preuve quelque chose que je dénonce depuis une dizaine d’année et qui relève d’une schizophrénie gouvernementale. On a d’un côté l’ANSSI qui est l’agence en France en charge de la cyber-défense qui explique aux voyageurs d’affaires que, quand ils vont à l’étranger, ils doivent chiffrer leurs disques durs et leurs communications, utiliser des VPN et des logiciels de chiffrement, car ils risquent d’être victimes d’espionnage industriel. De l’autre côté, on a la CNIL qui est plus grand public. Lorsque vous allez sur leur site pour protéger votre vie privée, on va vous apprendre à gérer vos cookies et à paramétrer Facebook. Ils n’expliquent pas comment utiliser un VPN, comment utiliser PGP, comment utiliser Signal, comment utiliser un logiciel de chiffrement… Encore aujourd’hui, pour beaucoup, dès qu’on parle de chiffrement, cela veut dire que l’on va expliquer aux gens comment devenir des gangsters, des terroristes ou des pédophiles. Pour moi, cela relève d’une forme de schizophrénie. Soit on explique aux gens comment se protéger, soit on ne leur explique pas. Les pouvoirs publics sont encore très réticents par rapport au chiffrement. La quasi-totalité du temps, quand un homme politique parle de Telegram, de Signal, du Dark Web ou de Tor, c’est en référence aux terroristes, aux gens qui veulent acheter de la drogue ou aux pédophiles alors que la majeure partie de l’utilisation du chiffrement ne relève absolument pas du terrorisme, de la pédophilie ou du trafic de drogue. C’est un épiphénomène. On en revient à l’analogie que je faisais tout à l’heure. Il y a une diabolisation d’Internet que j’essaye de fustiger dans le documentaire et qui, néanmoins, continue et va continuer encore très longtemps.

Quels sont vos projets actuels ? Avez-vous d’autres projets de films ou de livres qui prolongeraient Une contre-histoire de l’Internet ?

On m’avait proposé de faire un livre d’Une contre-histoire de l’Internet mais un livre prend beaucoup de temps. C’est un exercice que je n’aime pas trop. J’ai décliné la proposition. J’ai d’autres projets. L’un a été diffusé à l’automne dernier sur France Télévision. On peut encore le voir sur Youtube. C’est un numéro de Cash Investigation, le magazine de France 2, consacré aux marchands de technologies de surveillance. Je parlais de vidéosurveillance, de biométrie… C’était donc un peu une contre-histoire des technologies de surveillance. Sous Nicolas Sarkozy, il y a quelques années, la loi a été modifiée pour faire de telle sorte qu’on ne parle plus de « vidéo-surveillance » en France mais de « vidéo-protection ». C’était comme si les caméras, sur leurs poteaux, pouvaient protéger des êtres humains victimes d’agressions. Nice était la ville la plus « vidéo-protégée » de France. Dans les jours qui ont précédé l’attentat, cela n’a pas empêché un terroriste de se balader plusieurs fois sur la Promenade des Anglais avec un camion alors que c’est interdit. Il y a des caméras. Elles ne l’ont pas identifié. Estrozi avait déclaré au moment des attentats de Charlie Hebdo que si Paris s’était inspiré du modèle niçois en matière de vidéo-protection, les frères Kouachi n’auraient pas franchi quatre carrefours. Il l’avait dit au conseil municipal à Nice. La preuve en est que les caméras à Nice n’ont pas empêché quelqu’un de franchir deux kilomètres sur la Promenade des Anglais et de faire 80 morts. L’émission pour Cash a été faite avant l’attentat mais j’y parlais de la vidéo-surveillance comme quelque chose qui crée un faux sentiment de protection. Un peu comme tous ces discours anxiogènes sur Internet, la majeure partie des discours qui sont tenus concernant la biométrie, la vidéo-surveillance et les technologies soi-disant censées nous sécuriser, créent un sentiment de sécurité mais n’améliorent pas sensiblement la sécurité. Ce n’est pas de la vidéo-protection ! Au mieux, c’est de la vidéo-élucidation parce que les images de vidéosurveillance peuvent éventuellement contribuer à « élucider » des crimes ou des délits, mais en aucun cas à « protéger » les gens qui en sont les victimes !

J’ai d’autres projets de l’ordre de la contre-histoire appliquées aux fichiers policiers. En France, une personne sur six est fichée comme « défavorablement connue des fichiers de police ». Quasiment personne ne le sait ! Une personne sur six, c’est juste hallucinant ! La réalité du fichage policier en France, c’est ça. J’ai aussi des projets concernant la preuve par l’ADN. Pour beaucoup de gens, la preuve par l’ADN, c’est la preuve ultime, la reine des preuves. C’est scientifique. En fait, la preuve par l’ADN, c’est exactement comme la biométrie : c’est un calcul de probabilité. Un calcul de probabilité, c’est des maths, ce n’est pas de la science. La majeure partie des gens ne le savent pas. Il y a des erreurs judiciaires qui ont été documentées : des gens ont été inculpés à tort parce qu’un expert a dit : « C’est son empreinte génétique qu’on a retrouvé sur la scène de crime ! » et il s’était trompé dans ses calculs de probabilité.

Quelque chose sur lequel je travaille depuis pas mal d’années maintenant, c’est sur ce qu’on appelle les morts aux frontières : tous ces exilés qui essayent de trouver refuge en Europe. On en arrive à 30.000 morts documentées depuis l’an 2000. « Documentées », cela veut dire qu’il y en a beaucoup plus en réalité. J’ai commencé à faire un travail là dessus parce que, depuis Schengen, l’essentiel de la politique européenne et de l’argent des instances européennes va dans la sécurisation des frontières. Or plus on sécurise les frontières, plus cela fait de morts. La solution ne peut pas être de ce côté là.

Dans Les Saintes du scandale (Folio, Gallimard, 2013), l’écrivain Erri De Luca évoque le musée d’Ellis Island qui documente les vagues de l’émigration américaine. Selon lui, à Lampedusa, les autorités ont détruit tout ce qui aurait pu faire partie d’un futur musée de l’émigration. Internet pourrait-il être un espace où se constitueraient ce musée et cette mémoire ?

Il y a un monument et un cimetière à Lampedusa. Une partie de la population fait un travail remarquable. Ils sont vent debout contre les instances européennes. J’ai contribué à faire sur Owni un mémorial des morts aux frontières à une époque où, lorsqu’on parlait des réfugiés morts, c’était du fait divers. à l’époque, il n’y avait que des ONG qui comptabilisaient les migrants. En 2014, on a fait un projet avec Nicolas Kaiser-Bril et d’autres journalistes européens qui s’appelle The Migrants Files. On a fusionné deux bases de données faites par un bloggeur italien et par une ONG aux Pays-Bas. On en est arrivé à ce chiffre, en 2013-2014, de 30.000 morts comptabilisés depuis l’an 2000. Une des choses que nous racontions dans notre enquête, c’est qu’aucune des instances nationales ou internationales, l’Europe, Frontex, les Nations Unies, l’Organisation internationale pour les migrations, ne comptabilisait les morts aux frontières. J’avais contacté un des officiers responsables de Frontex, l’agence en charge de la sécurisation des frontières extérieures de l’Union européenne, pour lui demander comment cela se faisait que, dans leurs rapports annuels, il y avait des tonnes de chiffres sur tous les migrants interceptés, placés en camps de rétention, refoulés dans leur pays et zéro chiffre sur les morts aux frontières. En off, cet officier m’a dit : « Mon boulot, c’est de lutter contre l’immigration illégale. Ces gens-là sont morts, donc ce ne sont plus des migrants. » Pour moi, c’était révélateur de la différence fondamentale de perception géopolitique du monde : j’ai en face de moi quelqu’un payé avec notre argent pour sécuriser les frontières qui, face à quelqu’un qui est mort, ne se pose pas de questions sur les raisons de sa mort. Il est dans une logique verticale. Moi, simple être humain, par ailleurs journaliste, quand je découvre qu’il y a 30.000 morts aux frontières, ça me révulse ! Je ne comprends pas que les instances européennes laissent faire ce massacre sans réagir. Pour cet officier, la question ne se posait même pas. C’est la banalité du mal. C’est Hannah Arendt. Dans le monde horizontal d’Internet tel que je le perçois, on doit réagir contre le monde vertical et cette banalité du mal…

Notre enquête a fait du bruit. Depuis, nos chiffres ont été récupérés par les Nations Unies et par l’Organisation internationale pour les migrations. Aujourd’hui, ces instances comptabilisent au jour le jour les morts dont on arrive à retrouver la trace. Ils ont repris notre travail. C’est probablement une des choses dont je suis le plus fier d’un point de vue journalistique et simplement en tant qu’être humain ! Notre enquête a contribué à changer la donne. Une des hypothèses que j’avais formulées, c’est qu’on ne pourra pas résoudre ce problème des morts aux frontières si on ne le documente pas. Avant l’enquête, ce n’était pas documenté. Depuis, ça l’est par les autorités. C’est un premier pas !

Cette approche qui place l’humain au centre de votre travail est donc constante ?

Pour moi, tous mes projets participent de ce travail de déconstruction qui fait référence au travail d’Howard Zinn évoqué précédemment : généralement, l’histoire est racontée par celui qui a gagné la guerre et ce qui m’intéresse c’est de raconter l’histoire du point de vue de l’être humain. Quand j’ai commencé à me connecter à Internet, Laurent Chemla m’avait dit : « La grosse différence entre Internet et la télévision, c’est que Bill Clinton (il était alors président des Etats-Unis) a une adresse email et toi aussi. » Sur Internet, on est tous égaux ! Ce n’est pas le cas dans les autres médias. Une bonne partie de mon travail journalistique part de ce postulat : ne pas être dans la logique top-down mais dans la logique bottom-up. C’est ce que j’ai essayé de montrer dans La contre-histoire de l’Internet.

Entretien réalisé par Alain Hertay, le 29 juillet 2016

Né en 1971, Jean-Marc Manach est un

Né en 1971, Jean-Marc Manach est un  Tout est parti de David Dufresne. En 1995, a

Tout est parti de David Dufresne. En 1995, a Le titre du film est un hommage au livre

Le titre du film est un hommage au livre  C’est le livre

C’est le livre  C’est plus qu’une anecdote, cela relève de l’histoire. C’est fondamental pour comprendre ce que permet la télématique, ce que permet Internet. c’est quelque chose de l’ordre de l’horizontalité et non pas de la verticalité comme l’était le Minitel. On raconte ça dans le film. Jean Guisnel a écrit un livre au début des années 90,

C’est plus qu’une anecdote, cela relève de l’histoire. C’est fondamental pour comprendre ce que permet la télématique, ce que permet Internet. c’est quelque chose de l’ordre de l’horizontalité et non pas de la verticalité comme l’était le Minitel. On raconte ça dans le film. Jean Guisnel a écrit un livre au début des années 90,  Il en manque bien évidemment. Le premier jour de tournage, on est allé interviewer Laurent Chemla qui n’apparaît pas au montage. C’est quelqu’un de très important dans ma compréhension d’Internet. Son livre,

Il en manque bien évidemment. Le premier jour de tournage, on est allé interviewer Laurent Chemla qui n’apparaît pas au montage. C’est quelqu’un de très important dans ma compréhension d’Internet. Son livre,  C’était la personne la plus compliquée à interviewer pour des raisons faciles à comprendre. Il était enfermé dans l’ambassade d’Equateur. Il ne pouvait pas sortir. Lui, il n’est pas parano. Il est surveillé en permanence ! Je ne sais plus combien de millions sont dépensés chaque année pour surveiller l’ambassade d’Equateur à Londres. C’est une

C’était la personne la plus compliquée à interviewer pour des raisons faciles à comprendre. Il était enfermé dans l’ambassade d’Equateur. Il ne pouvait pas sortir. Lui, il n’est pas parano. Il est surveillé en permanence ! Je ne sais plus combien de millions sont dépensés chaque année pour surveiller l’ambassade d’Equateur à Londres. C’est une  Il y a une anecdote qui n’est pas dans le film et que je raconte dans une BD sortie l’an dernier intitulée

Il y a une anecdote qui n’est pas dans le film et que je raconte dans une BD sortie l’an dernier intitulée

La loi renseignement, adoptée dans la foulée des révélations Snowden sur la « surveillance de masse« , a été présentée par ses opposants comme permettant « une interception de l’ensemble des données des citoyens français en temps réel sur Internet« . La DGSE espionne-t-elle tous les Français ? En a-t-elle le droit, les moyens techniques, et financiers ? #Oupas…? [tl;dr : non]

La loi renseignement, adoptée dans la foulée des révélations Snowden sur la « surveillance de masse« , a été présentée par ses opposants comme permettant « une interception de l’ensemble des données des citoyens français en temps réel sur Internet« . La DGSE espionne-t-elle tous les Français ? En a-t-elle le droit, les moyens techniques, et financiers ? #Oupas…? [tl;dr : non]

Certes, ce qui intéresse le plus les services de renseignement, ce sont les méta-données (qui communiquent avec qui, d’où, quand ?), et la surveillance pourrait être automatisée. Encore faudrait-il que les services puissent intercepter, stocker et analyser toutes ces données. Sauf qu’en France, le trafic Internet est particulièrement

Certes, ce qui intéresse le plus les services de renseignement, ce sont les méta-données (qui communiquent avec qui, d’où, quand ?), et la surveillance pourrait être automatisée. Encore faudrait-il que les services puissent intercepter, stocker et analyser toutes ces données. Sauf qu’en France, le trafic Internet est particulièrement