De la loi sur les indisponibles au registre ReLIRE : la blessure, l’insulte et la réaction en marche

dimanche 24 mars 2013 à 19:39Tous les acteurs impliqués dans le dossier de la numérisation des livres indisponibles voulaient que l’ouverture du registre ReLIRE au moment du Salon du Livre constitue une célébration, mais cette petite fête risque bien d’être gâchée, tant les réactions d’indignation se multiplient à l’encontre du dispositif mis en place.

Au vu des dispositions fixées par la loi et précisées dans le décret d’application, on savait déjà qu’un déséquilibre patent avait été instauré dans ce système au bénéfice des éditeurs et au détriment des auteurs. Mais on aurait tout de même pu penser que la base ReLIRE serait conçue de manière suffisamment rigoureuse pour faciliter la possibilité de retrait volontaire que la loi a prévu dans les six mois après l’inscription d’un livre au registre (opt-out).

Une affiche de mai 68 conservée à la BnF, qui prend une saveur particulière depuis la mise en ligne de la base ReLIRE…

Non seulement il n’en est rien, mais le registre ReLIRE contient des erreurs lourdes, épaisses et manifestes, dont on se demande comment elles ont pu seulement être commises.

Violations frontales de la loi

Comme l’a signalé @BlankTextField ici, ReLIRE comporte visiblement d’étranges erreurs. On y trouve par exemple 538 titres publiés postérieurement au 1er janvier 2001, qui ne sont donc pas couverts par la loi du 1er mars 2012. Plus surprenant encore, ReLIRE contiendrait quelques rééditions de livres publiés au 18ème et 19ème siècle, ainsi que de simples reprints, qui n’ont absolument rien à y faire… La BnF était censée jouer le rôle de « tiers de confiance » dans le dispositif, mais de telles erreurs risquent bien de la transformer aux yeux de beaucoup en un véritable « tiers de défiance »…

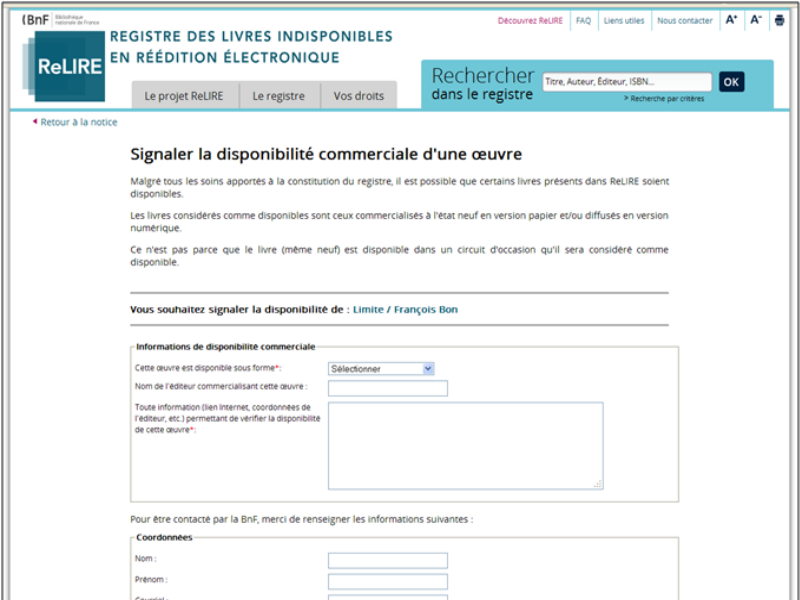

Mais le pire, comme François Bon l’a signalé dans ce billet poignant, c’est qu’un certain nombre de titres ont été inclus dans le registre, alors même qu’ils sont encore disponibles en papier ou en numérique. Que l’on soumette les auteurs d’ouvrages indisponibles à un opt-out est déjà une chose très contestable en soi (comme il est expliqué ici), mais que des auteurs de livres encore disponibles soient soumis à cette procédure, sous peine de voir leurs droits aspirés en gestion collective, c’est tout simplement une violation frontale de la loi.

ReLIRE pousse l’ironie jusqu’à avoir mis en place un formulaire pour signaler qu’un titre figurant dans la base est en réalité disponible, comme s’il s’agissait d’une simple erreur à rectifier, alors qu’il s’agit de violations de la loi ! Je dirai ça à la police, la prochaine fois que je suis pris en excès de vitesse : merci de me le signaler ! Combien d’auteurs sont dans ce cas (peut-être des milliers de titres au vu des signalements…) ? Et comment feront-ils s’ils laissent passer le délai de 6 mois, au-delà duquel il deviendra beaucoup plus difficile pour les auteurs de faire valoir leurs droits ?

Opt-in pour les éditeurs ?

Il est difficile de comprendre comment de telles bévues ont pu être commises. Comment un simple tri par dates n’a pas été effectué avant la publication et comment, sur une liste de 60 000 titres, il n’a pas été possible d’éviter de tels dommages collatéraux ? 60 000 références, on n’est quand même pas dans le Big Data ! En réalité, si l’on observe froidement les choses, il est assez facile de comprendre ce qui s’est passé : l’objectif a manifestement été de publier cette première liste en avançant à marche forcée avant le Salon du Livre, à des fins d’affichage politique et tant pis si au passage, on écrasait quelques auteurs !

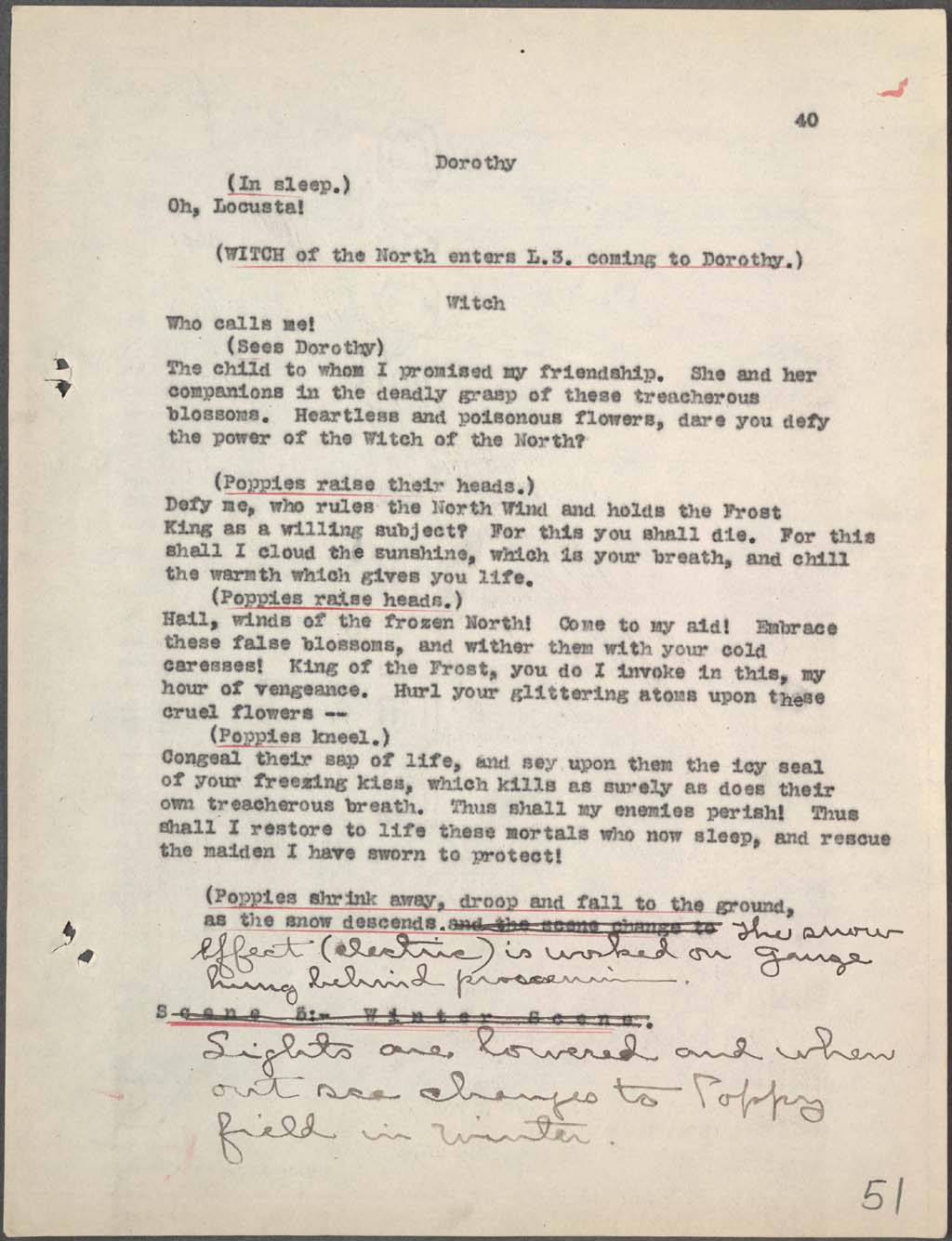

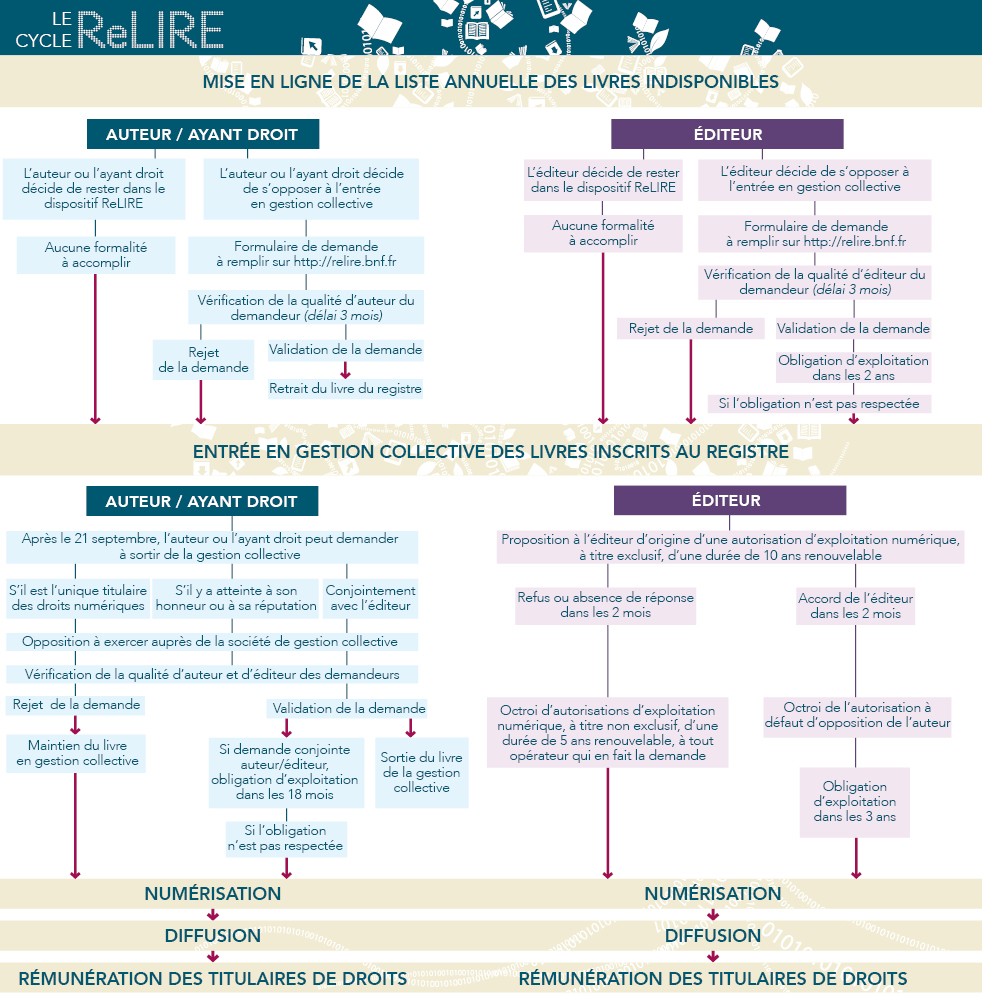

Les Indisponibles ? Ho, c’est très simple. Reportez-vous à ce schéma (fourni sans tube d’aspirine !).

Le ridicule a été poussé jusqu’à nommer par arrêté un « conseil scientifique » le 20 mars, dont la mission consiste justement à définir les critères et la méthode d’établissement de la liste des ouvrages inclus dans la base. Or cette fameuse liste a été publiée dès le lendemain, en même temps que le Registre ReLIRE. On en déduit soit que les membres de ce conseil sont des surhommes qui ont abattu le travail de sélection de 60 000 livres en une nuit, soit que la besogne a été accomplie ailleurs – on ne sait où, par qui et comment – avec à la clé, les ratages qui éclatent au grand jour à présent.

Parlons donc plutôt de caution que de conseil scientifique et un document interne de la BnF, publié sur Actualitté, a montré qu’il faut lire autre chose que l’arrêté pour comprendre comment les choses fonctionnent en réalité… Une partie de ces titres a été sélectionnée dans le cadre d’un marché passé avec Electre, mais le document indique aussi que 10 000 ouvrages auraient été « fournis par les éditeurs ». Qu’est-ce que cela peut signifier ? Mystère, sinon que l’on voit que les éditeurs bénéficient en réalité sans doute d’une forme d’opt-in, puisqu’ils ont la main sur la liste, alors que les auteurs de leur côté restent individuellement soumis à l’opt-out. Cette « cuisine interne » aboutit à quelque chose de vraiment pire que tout ce que l’on pouvait imaginer !

Les chiens ne font pas des chats…

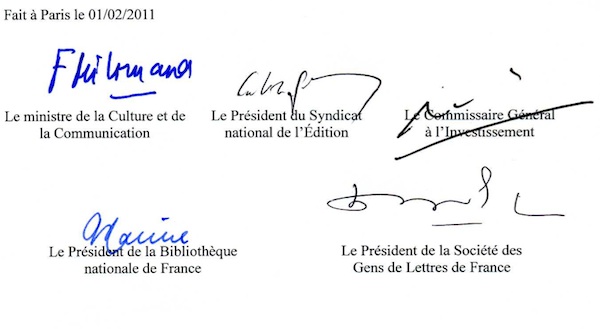

Il est vrai que d’un bout à l’autre, cette affaire des livres indisponibles aura été marquée par l’opacité et le manque de transparence. Bouclé très en amont du vote de la loi, dans un accord-cadre conclu en secret entre le Ministère de la Culture, le SNE, la SGDL et la BnF, le dispositif général des Indisponibles est le résultat de tractations qui n’ont rien à voir avec le débat démocratique que l’on aurait été en droit d’attendre sur un sujet aussi important.

Le gouvernement a ensuite demandé, sans aucune justification réelle, à ce que la loi soit votée en urgence, ce qui présentait l’avantage de rendre le débat plus difficile devant les assemblées. Et à présent, aux commandes de cette base, nous retrouvons les mêmes acteurs qu’au départ, le nouveau gouvernement socialiste ayant choisi d’ignorer les critiques, émanant notamment du collectif d’auteurs Le Droit du Serf, qui proteste depuis des mois contre la spoliation en cours de leurs droits.

01/02/2011 : un an avant le vote de la loi, tout était déjà prévu à l’avance, dans un accord secret, qui n’a été révélé que sur l’insistance de certains députés, à la toute fin des débats parlementaires…

Les chiens ne font pas des chats, dit-on, et il était logique qu’une loi accouchée dans ces conditions débouche sur une telle mise en oeuvre.

Beaucoup de choses ont déjà été écrites à propos de cette loi sur les indisponibles, mais je voudrais rappeler rapidement les principaux points qui font que, vis-à-vis des auteurs, des bibliothèques et du public, ce dispositif est inacceptable.

Malheur à Petit Auteur !

Cette loi entérine en premier lieu le lent processus de déchéance du droit d’auteur en un droit d’éditeur, avec la bienveillance de l’Etat. Normalement, un éditeur qui laisse un ouvrage devenir indisponible commercialement commet un manquement vis-à-vis de ses obligations vis-à-vis de l’auteur, susceptible de faire tomber le contrat d’édition et d’entraîner un retour complet des droits à l’auteur. On appelle cela le « défaut d’exploitation permanente et suivie », mais pour le constater, le Code de Propriété Intellectuelle a prévu une procédure compliquée, attestant que le livre est bien « épuisé », qui fait que peu d’auteurs n’obtiennent en réalité le retour effectif de leurs droits.

L’artifice majeur de la loi du 1er mars 2012 consiste à avoir déclaré qu’un livre signalé indisponible dans le registre ReLIRE ne devait pas être considéré comme épuisé au sens de la loi. Matériellement pourtant, c’est exactement la même chose, mais juridiquement cela permet à l’éditeur de conserver le bénéfice du contrat d’édition, quand bien même il s’est mis en faute vis-à-vis de l’auteur. Et cet auteur, qui devrait bénéficier de l’intégralité des droits, va être obligé une fois son livre entré en gestion collective de partager les revenus de l’exploitation de l’ouvrage à 50/50 avec son éditeur. Les éditeurs empochent donc une masse de droits sur l’exploitation numérique du patrimoine écrit du XXème siècle, sans avoir à bouger le petit doigt. Passé six mois, la société de gestion viendra même lui apporter sur un plateau la possibilité de récupérer ces droits, avec un beau courrier recommandé ! Si l’on met de côté la morale et le respect de l’esprit du Code, il faut bien reconnaître que cette manoeuvre constitue un véritable coup de maître !

Évidemment me direz-vous, les auteurs peuvent s’opposer à l’entrée de leurs ouvrages en gestion collective en faisant jouer l’opt-out qui leur est ouvert pendant 6 mois. Mais outre le fait que cela ne règle en rien la question du retour des droits dans leur giron, nous avons maintenant la preuve éclatante que cette procédure est tout sauf simple à exercer, surtout au vu de la manière dont la base ReLIRE a été conçue. J’avais écrit l’an dernier un billet pour montrer que les auteurs risquaient d’être soumis à un véritable parcours du combattant, mais je pensais quand même qu’il leur serait relativement facile de sortir du dispositif dans les premiers six mois. Le billet écrit par François Bon, qui s’est frotté à la procédure, est là pour nous montrer qu’il n’en est rien… Voilà ce qui fait dire à Yal Ayerdhal, l’un des principaux opposants à ce système, que nous sommes confrontés à un véritable piratage d’Etat ! Loin d’avoir fait mieux que Google, la France a employé exactement les mêmes procédés douteux que le moteur de recherche, avec les mêmes conséquences à la clé.

Désastre pour les bibliothèques et l’intérêt du public

Pour prendre la mesure du désastre, il faut également prendre en compte la situation des bibliothèques, et pour cela, se rappeler qu’il existe en France d’autres bibliothèques que la BnF (ce que beaucoup d’acteurs ont dramatiquement tendance à oublier…).

Les bibliothèques sont également de grandes perdantes dans cette affaire, car si cette loi a été votée en urgence, c’est en grande partie pour prendre de vitesse et contrer une directive sur les œuvres orphelines votée en octobre 2012, qui leur aurait été plus favorable. Car dans le corpus des ouvrages indisponibles, une part significative doit être constitué d’oeuvres orphelines, pour lesquelles les auteurs par définition ne réagiront pas. C’est ce que j’avais appelé « la grande manoeuvre des indisporphelines » : englober les orphelines mécaniquement dans les indisponibles grâce à l’opt-out, ce que Google avait lui aussi essayé de faire dans son règlement et que la Justice américaine lui a refusé.

Or la directive européenne prévoyait un système différent par lequel les bibliothèques françaises, après avoir établi par des recherches diligentes que les ouvrages étaient bien orphelins, auraient pu numériser et mettre en ligne gratuitement les ouvrages à la disposition du public. Il y a fort lieu de penser que cette possibilité de diffusion gratuite a complètement affolé les titulaires de droits en France, qui ont utilisé l’artillerie lourde de leur lobbying pour neutraliser la directive au profit du système des Indisponibles. L’idée d’un accès privilégié en bibliothèque est quand même revenue par le biais du Sénat, mais elle a été à nouveau consciencieusement démantelée dans le texte final de la loi…

Vue par les acteurs à l’origine de la loi sur les indisponibles, voilà à quoi ressemble une bibliothèque (par GreenViking. CC-BY-NC-SA)

Alors que restera-t-il au final aux bibliothèques ? Comme d’habitude, elles seront considérées comme de simples vaches à lait, à qui l’on proposera des abonnements payants pour l’accès à des produits conçus à partir des indisponibles. Et c’est d’autant plus choquant que la numérisation des ouvrages sera financée en partie avec l’argent public du Grand Emprunt, sans aucune contrepartie en matière d’accès public. On retrouve les mêmes dérives que dans l’affaire Proquest de numérisation du domaine public à la BnF. Et que la première des bibliothèques de France puisse à nouveau jouer un rôle central dans cette affaire n’en est que plus choquant. Silvère Mercier écrivait ceci sur son blog il y a quelques mois, qui reste cruellement d’actualité :

Ils ne voient pas l’erreur historique qu’aura été l’absence de mobilisation générale de notre Bibliothèque Nationale pour un accès public et libre aux œuvres orphelines. A un moment donné, la stratégie d’un établissement s’oppose aux intérêts de l’ensemble des politiques publiques dont il est censé être le navire amiral… Quelle occasion manquée de devoir se soumettre au diktat des éditeurs et de sécuriser les accès ! Quelle soumission aveugle au sacro-saint secteur privé ! Rappelons que l’argument massue, l’argument économique, ne tient pas une seconde puisque les éditeurs eux-mêmes via le SNE nous avaient fait part d’une étude démontrant la très faible rentabilité du marché des indisponibles… Ce sont bien les bibliothèques comme bras (dés)armé de l’accès pour tous à l’information qui sont entravées par les chaînes économiques du livre !

Et le public dans cette histoire ? Il sera lui aussi perdant, car comme nous l’avons dit plus haut, bien que de l’argent public soit mobilisé pour la numérisation des indisponibles, aucune contrepartie en terme d’accès public n’est prévue, même pas pour les usages pédagogiques et de recherche par exemple. Le public perd aussi le bénéfice qu’il aurait pu retirer de la mise à disposition gratuites des oeuvres orphelines, si la directive européenne avait pu s’appliquer en France. Et last but not least, comme la BnF a décidé de sacrifier la numérisation d’une partie des oeuvres du domaine public pour affecter l’argent à la numérisation des 10 000 premières oeuvres indisponibles, le public perdra aussi l’accès gratuit dans Gallica à ces ouvrages anciens…

Destruction des autres possibles

Certaines voix ne sont pas d’accord avec ces critiques. Emmanuelle Bermès par exemple a écrit sur son blog un billet dans lequel elle s’étonne de l’opposition qui s’exprime contre la base ReLIRE :

On ne peut pas à la fois critiquer la loi sur le droit d’auteur dans le fait qu’elle est inadaptée au monde numérique, et en même temps tirer à boulets rouges sur la première initiative visant à essayer de trouver des solutions intermédiaires.

Se ranger du côté du « pragmatisme » est bien commode (et très à la mode…), mais à titre personnel, c’est bien parce que je critique l’inadaptation du droit d’auteur au numérique que je juge complètement inacceptable la loi sur les Indisponibles et le dispositif ReLIRE. Philippe Aigrain sur son blog a très bien expliqué que la loi sur les Indisponibles avait eu pour objectif principal de fermer la porte à d’autres solutions plus équilibrées :

[...] la loi sur les œuvres indisponibles est un plan concerté pour la destruction d’un possible et son remplacement par une trajectoire indésirable pour l’immense majorité d’entre nous.

Des alternatives existaient, qui auraient permis de mettre en place des solutions bien plus équilibrées, sans tordre le cou aux principes les plus essentiels du droit d’auteur. Concernant les oeuvres indisponibles, la seule solution équitable était celle du retour automatique des droits à l’auteur et l’inclusion des oeuvres dans le registre sur la base d’un opt-in strict. Aux Etats-Unis, la justice américaine en est arrivé à la conclusion dans le procès Google que l’opt-out est trop dangereux, parce qu’il peut engendrer trop de dérives, mais en France au Pays de Beaumarchais, nous l’avons maintenu. C’est complètement incompréhensible !

Par ailleurs, pour la partie des oeuvres orphelines au sein des indisponibles, le mécanisme prévu par la directive européenne garantissait une solution plus équilibrée, même si elle n’était pas parfaite. Le cas des oeuvres orphelines est très délicat et il faut en la matière éviter au maximum les risques de réappropriation. Dès lors, seule la diffusion non-marchande d’une oeuvre orpheline est acceptable, dans un but d’intérêt général, et c’est exactement ce que prévoit la directive. Les bibliothèques auraient pu assurer cette diffusion et la BnF se serait honorée dans une telle entreprise, alors qu’à la place la loi française organise un transfert des droits sur les orphelines vers une société de gestion collective, qui les exploitera commercialement sans retour financier possible vers les auteurs. C’est profondément injuste et socialement néfaste, même si certains y trouvent leur compte…

Pathétique château de cartes…

Philippe Aigrain estime dans son billet que les dysfonctionnements repérés dans cette affaire des Indisponibles sont si lourds qu’il faut commencer à parler de « corruption des institutions » :

J’utilise pour décrire ce processus d’ensemble une expression qui a été mise en avant par l’Edmund J. Safra Center for Ethics de Harvard à partir d’une initiative de Lawrence Lessig : la corruption des institutions. Elle résulte d’une collusion entre des intérêts privés établis (ici les grands éditeurs) et institutionnels (certaines formes de gestion collective), un ensemble limité de personnes priviligiées (les gros percepteurs des revenus de droits ou de la gestion collective) et des visions de l’action publique dont le but est de servir ces intérêts (la DGMIC) ou d’en capturer des bénéfices dérivés (la direction de la BnF). Cette collusion produit ses effets à travers les réseaux que tissent ces acteurs pour influencer la production de la loi et les nominations des responsables de l’action publique (y compris les élus) et pour organiser les marchés à leur profit.

Je parlerai volontiers pour ma part de décomposition de l’action publique, qui commence à devenir singulièrement inquiétante en matière de politique du livre, depuis maintenant des années. Les lois se succèdent, issues de petits cercles qui se côtoient et se connaissent, loin de la lumière du débat public. L’alternance politique n’a rien changé au problème, en grande partie parce que les équipes ministérielles n’ont pas bougé. J’avais été glacé par exemple de constater que deux instigateurs importants de cette loi sur les indisponibles, votée sous l’ancien gouvernement, ont été élevés à la dignité de Chevaliers des Arts et des Lettres par Aurélie Filippetti (je vous laisse chercher...). Et tout porte à croire que le pouvoir en place, au plus haut niveau, soutiendra jusqu’au bout cette loi sur les indisponibles et le dispositif ReLIRE.

Pour beaucoup, l’ouverture de la base ReLIRE a ajouté l’insulte à la blessure qu’avait constituée le vote de la loi du 1er mars 2012. Mais la réaction est déjà en marche et elle sera à la mesure du mépris dont les instigateurs de ce texte ont fait preuve !

Comme le rappelle souvent le site Actualitté, il existe une faille béante dans toute cette machinerie des Indisponibles, qui ne peut plus être refermée à ce stade. De très lourds soupçons d’inconstitutionnalité pèsent en effet sur le texte, et sa conformité avec la Convention de Berne fait question. Pour mettre en oeuvre la base ReLIRE, le gouvernement devait nécessairement prendre un décret, mais publier cet acte, c’était exposer le flanc à un recours au Conseil d’Etat et plus loin ensuite, devant le Conseil constitutionnel qui a le pouvoir d’annuler la loi.

Tout le dispositif des Indisponibles peut donc s’effondrer brutalement comme un château de cartes, sanctionné par les plus hautes juridictions de ce pays. Il sera alors temps de démêler l’écheveau des responsabilités qui ont pu conduire à ce véritable fiasco pour l’intérêt public…

Classé dans:Bibliothèques, musées et autres établissemerents culturels, Edition numérique, aspects juridiques Tagged: auteurs, éditeurs, BnF, contrat d'édition, directive, indisponibles, loi, Numérisation, oeuvres orphelines, ReLIRE

![]()