Littlewing : Insérer des données issues d’un fichier CSV dans ELASTICSEARCH

mercredi 21 janvier 2015 à 15:32Un cas que j’ai du implémenter avec le même schéma que précédemment:

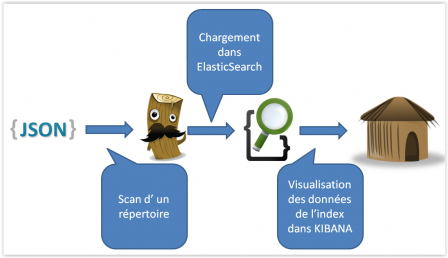

Prendre des fichiers CSV en entrée et les insérer facilement dans ELASTICSEARCH au fil de l’eau. J’ai donc utilisé LOGSTASH pour réaliser cette manipulation.

Cet outil sert à la base comme agrégateur de logs. Il est désormais un mini ETL .

Configuration de LOGSTASH

input {

file {

codec => plain{

charset => "ISO-8859-1"

}

path => ["/data/input/*.csv"]

sincedb_path => "/data/.sincedb_path"

start_position => "beginning"

}

}

filter {

if [message] =~ /^"COL1","COL2"/ {

drop { }

}

csv {

columns => ["COL1","COL2",...]

separator => ","

source => message

remove_field => ["message","host","path","@version","@timestamp"]

}

}

output {

elasticsearch {

embedded => false

host => "localhost"

cluster => "elasticsearch"

node_name => "localhost"

index => "index"

index_type => "type"

}

}

Explication

Dans le champ input, je spécifie ou est le fichier, ou est l’indicateur de parcours et ou est-ce que je démarre la lecture du fichier

Dans le champ filter , j’ enlève la ligne d’en-tête, puis dans l’élément csv, je spécifie les colonnes et supprime les champs techniques

Enfin, dans l’élément output, j’indique les coordonnées du serveur elasticsearch

Exécution

Il faut d’abord exécuter elasticsearch. Puis démarrer l’instance logstash comme suit :

logstash.bat agent -v -f "input-csv.conf"

Original post of Littlewing.Votez pour ce billet sur Planet Libre.

Articles similaires

- Jérôme Launay : Convertir un fichier CSV en YAML avec python (13/12/2012)

- Littlewing : Effectuer une redirection permanente grâce au fichier htaccess (09/10/2009)

- Littlewing : Mon fichier .emacs (03/08/2010)

- Bardamu : Téléchargez le fichier source de « Panorama des licences libres » (13/12/2010)

- Littlewing : Mise à jour de mon fichier .emacs (18/01/2011)